インタラクティブなスニペットのデザイン

WWDC25

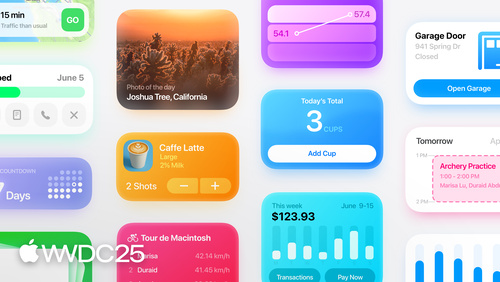

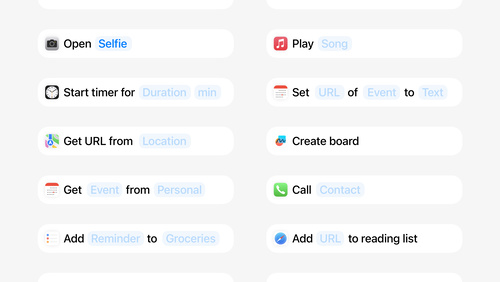

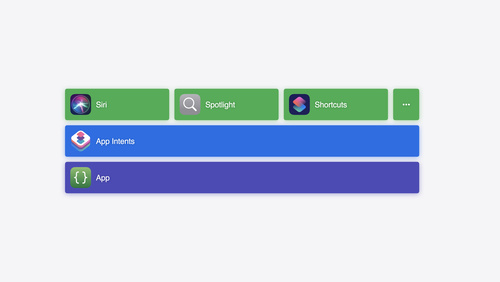

インタラクティブなスニペットのデザイン スニペットはApp Intentから呼び出されるコンパクトなビューで、アプリからの情報が表示されます。スニペットを使用し、インテントの一部として、追加の操作を提供するボタンやステートフルな情報を追加することで、Siri、Spotlight、ショートカットアプリにさらに多くの機能を提供できるようになりました。このセッションでは、レイアウト、タイポグラフィ、インタラクション、インテントタイプについてのガイダンスを含め、スニペットのデザインに関するベストプラクティスを紹介します。 contains solarium WWDC25

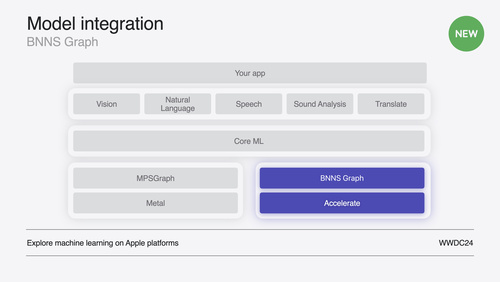

BNNS Graphの新機能

WWDC25

BNNS Graphの新機能 BNNS Graph Builder APIにより、デベロッパは使い慣れたSwift言語を使用してオペレーションのグラフを記述し、前処理と後処理のルーチンや小規模な機械学習モデルを生成できるようになります。BNNSはグラフを実行前にコンパイルし、オーディオ処理などのリアルタイムのユースケースや遅延が許容されないユースケースをサポートします。このセッションでは、昨年のBitcrusherの例を再検討し、別個のPythonファイルに依存することなく、オーディオエフェクトを完全にSwiftで実装することで、Swiftコンポーネントを簡素化します。BNNS Graph Builder... bnns,machine learning WWDC25

Code Along:Foundation Modelフレームワークによる、アプリへのオンデバイスAIの組み込み

WWDC25

Code Along:Foundation Modelフレームワークによる、アプリへのオンデバイスAIの組み込み Foundation Modelフレームワークを使用すると、SwiftUIアプリに生成AI機能を導入できます。優れた機能の構築に向けて、まずはフレームワークの基本知識を適用する方法を学びましょう。サンプルを用いたステップごとのデモで、自ら構築したツールによるモデルの補完、結果のストリーミング、パフォーマンスを高めるためのさらなる最適化を行う方法を解説します。 ai,app intents,codealong,codealong,machine learning WWDC25

InstrumentsによるCPUのパフォーマンス最適化

WWDC25

InstrumentsによるCPUのパフォーマンス最適化 Instrumentsの2つの新しいハードウェア支援ツールを使用して、Appleシリコン向けにアプリを最適化する方法を学びましょう。最初にアプリのプロファイリング方法を説明したあと、Processor Traceで呼び出される各関数を確認しつつ詳細を解説します。また、CPUカウンタの各種モードを使用したコード分析によりCPUのボトルネックを特定する方法についても説明します。 WWDC25

Metal 4による機械学習とグラフィックスの統合

WWDC25

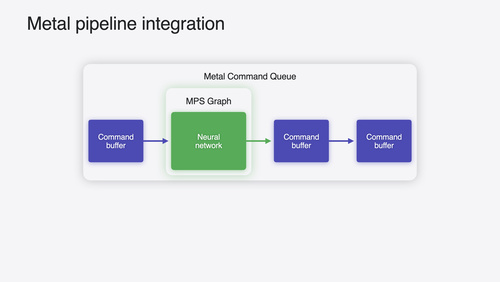

Metal 4による機械学習とグラフィックスの統合 Metal 4を使用してグラフィックスアプリに機械学習をシームレスに統合する方法を紹介します。レンダリングやコンピューティングのタスクと並行してGPUのタイムラインでモデルを実行するための、テンソルリソースとMLエンコーダの概要を説明します。シェーダMLにおいて、高度なエフェクトの適用と性能の向上のためにシェーダ内にニューラルネットワークを直接埋め込む方法を解説します。また、Metal 4のMLワークロード向けの新しいデバッグツールの使用例を、サンプルアプリを用いたデモでお見せします。 machine learning,metal,metal tools WWDC25

App Intentの基礎知識

WWDC25

App Intentの基礎知識 App Intentフレームワークの概要と、Appleのデベロッパプラットフォームにおいてますます重要性が高まっているこのフレームワークの役割について学びましょう。このセッションでは、インテント、エンティティ、クエリなどのコア概念を基本から解説します。これらの要素が連携することで、Spotlightやショートカットなどのソフトウェア機能とアクションボタンなどのハードウェア機能を実現するための、Appleデバイスを通じたアプリとApp Intentの統合が可能になります。今後Apple Intelligenceをアプリに統合する際のゲートウェイとしてApp... app intents,machine learning WWDC25

AppleシリコンでのMLXの導入

WWDC25

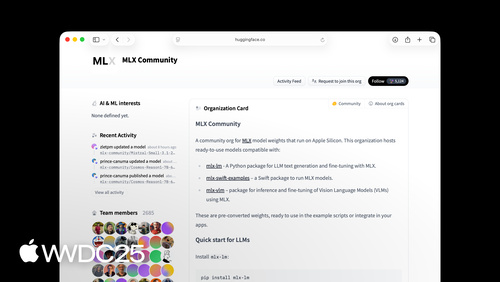

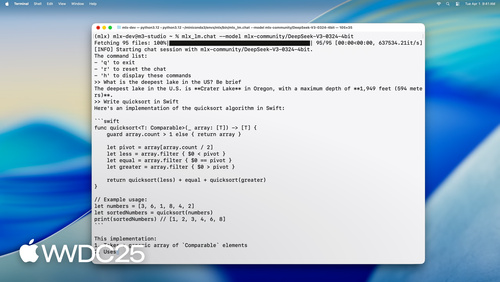

AppleシリコンでのMLXの導入 MLXは、Appleシリコン上で数値計算や機械学習を行うための柔軟で効率的な配列フレームワークです。ユニファイドメモリ、遅延計算、関数変換など、MLXの基本的な機能を解説します。また、SwiftとPythonのAPIを使用して、各種のAppleプラットフォーム上で機械学習モデルを構築、高速化するためのより高度な手法についても紹介します。 WWDC25

Foundation Modelフレームワークの詳細

WWDC25

Foundation Modelフレームワークの詳細 Foundation Modelフレームワークで開発のレベルを引き上げましょう。ガイド付き生成の仕組みを理解し、ガイド、正規表現、生成スキーマを使用してカスタムの構造化された応答を取得する方法を学べます。外部情報へのアクセスとアクションの実行をモデルが自発的に行うためのツール呼び出しを解説し、パーソナライズされた体験を実現する方法も紹介します。

このビデオの内容を十分理解できるよう、まず「Meet the Foundation Models framework」を視聴することをおすすめします。 ai,machine learning WWDC25

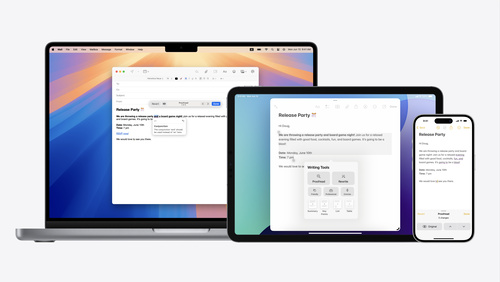

作文ツールの詳細

WWDC25

作文ツールの詳細 作文ツールを使用すると、アプリ内で直接テキストを校正したり、書き直したり、変換したりできます。アプリに合わせて作文ツールをカスタマイズするための高度なテクニックを学びましょう。いくつかのフォーマットオプションを紹介し、リッチテキストの編集でそれらがどのように機能するかについて説明します。カスタムテキストエンジンを使用している場合は、作文ツール体験全体をシームレスに統合し、テキストビューから直接編集できるようにする方法を説明します。 nsservices,nstextview,textkit,uitextview WWDC25

オンデバイス基盤モデルのためのプロンプトの設計と安全性の詳細

WWDC25

オンデバイス基盤モデルのためのプロンプトの設計と安全性の詳細 Foundation Modelフレームワークの強みを活かした生成AI体験をデザインします。まず、Apple Intelligenceの中心となるオンデバイス大規模言語モデルのプロンプトの設計方法について説明します。次に、AIの安全性に関する重要なアイデアを紹介し、生成AI機能の安全性、信頼性、使いやすさを向上させる具体的な戦略について説明します。 WWDC25

MLX:Appleシリコンでの大規模言語モデルの実行

WWDC25

MLX:Appleシリコンでの大規模言語モデルの実行 MLX LMは、Appleシリコン上での大規模言語モデルによる処理を簡単かつ効率的に行えるように設計されています。Mac上で最先端の大規模言語モデルのファインチューニングと推論を実行する方法、およびSwiftで開発したアプリやプロジェクトにそれらモデルをシームレスに統合する方法について説明します。 WWDC25

Foundation Modelフレームワークの紹介

WWDC25

Foundation Modelフレームワークの紹介 Apple Intelligenceを支えるオンデバイスの大規模言語モデルを活用する方法を学びましょう。この概要セッションでは、Swiftのデータ構造のガイド付き生成、応答性の高い体験を実現するストリーミング、コンテキスト管理のためのデータソースとセッションの統合を可能にするツール呼び出しなど、このフレームワークの機能を幅広く網羅しています。このセッションには、参加のための前提条件はありません。 ai,machine learning WWDC25

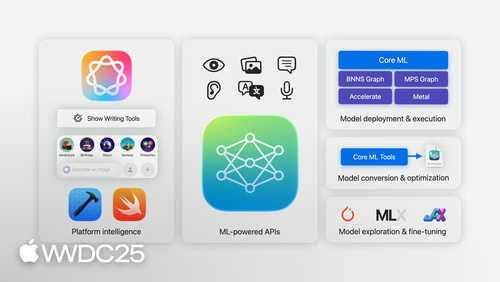

Appleプラットフォームでの機械学習/AIフレームワーク

WWDC25

Appleプラットフォームでの機械学習/AIフレームワーク Appleプラットフォームで利用可能な機械学習/AIフレームワークの最新アップデートを紹介します。アプリデベロッパが新たにApple Intelligenceを活用する場合でも、デバイス上にデプロイするモデルをMLエンジニアが最適化する場合でも、あるいはAIエキスパートが様々な可能性を追求する場合でも、各々のニーズに合った適切なツールを選択するためのガイダンスを提供します。 ai,machine learning WWDC25

App Intentの最新テクノロジーの詳細

WWDC25

App Intentの最新テクノロジーの詳細 今年のリリースでApp Intentフレームワークに追加されたすべての新しい機能強化を紹介します。デベロッパの生産性向上に役立つ機能強化(遅延プロパティなど)、および新機能(インタラクティブなApp Intentスニペット、エンティティビューの注釈、ビジュアルインテリジェンスの統合など)について説明します。これまで以上に表現力が高まると同時に、より簡単かつスムーズに導入できるようになったApp Intentについても詳しく説明します。さらに、今年App... app intents,machine learning WWDC25

App Intentを使用したショートカットおよびSpotlight向け機能の開発

WWDC25

App Intentを使用したショートカットおよびSpotlight向け機能の開発 MacのショートカットおよびSpotlightでのアクションを実現するApp Intentを構築して、これらのアプリの新機能と効果的に連携させる方法を学びましょう。作成したアクションと、ショートカットアプリで利用できる新しいApple Intelligenceアクションを強力に組み合わせる方法を説明します。新しい「Use Model」アクションがどのように機能し、アプリのエンティティとどのように相互作用するかについて詳しく解説します。さらに、App Intents APIを使用してSpotlightでアクションを提供する方法も確認します。 ai,app intents,machine learning,spotlight,spot light WWDC25

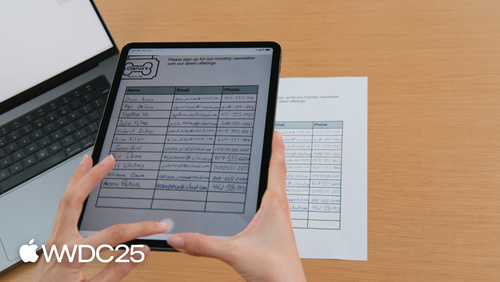

Visionフレームワークによるドキュメントの読み込み

WWDC25

Visionフレームワークによるドキュメントの読み込み Visionフレームワークの最新機能を紹介します。RecognizeDocumentsRequestの概要と、この要素をテキスト行の読み取りとパラグラフへのグループ化、表の読み込みなどに使用する方法を説明します。また、カメラレンズの汚れ検出や、写真ライブラリやカメラキャプチャパイプラインの画像の潜在的な汚れを識別する方法についても詳しく解説します。 machine learning amp vision WWDC25

SpeechAnalyzer:高度な音声テキスト変換をアプリに追加

WWDC25

SpeechAnalyzer:高度な音声テキスト変換をアプリに追加 新しいSpeechAnalyzer APIによる音声テキスト変換について説明します。メモ、ボイスメモ、ジャーナルなどの機能をパワーアップするSwift APIとその機能について学びましょう。音声をテキストに変換する仕組みを紹介し、エキサイティングで高性能な機能を実現するSpeechAnalyzerとSpeechTranscriberについて詳しく解説します。Code Alongでは、SpeechAnalyzerとライブトランスクリプションをアプリに取り入れる方法を紹介します。 machine learning,speechtotext WWDC25

CPUでリアルタイムのML推論をサポート

WWDC24

CPUでリアルタイムのML推論をサポート BNNSGraphを使用して、CPUでの機械学習モデルの実行を高速化する方法を解説します。BNNSGraphを使用してCPUで機械学習モデルをコンパイルし、実行する方法を示すとともに、実行時のメモリ割り当てが不要であることや、音声または信号の処理モデルをシングルスレッドで実行できることなど、BNNSGraphが提供するリアルタイムの保証についてもご紹介します。 bnns,machine learning WWDC24

Writing Toolsの導入

WWDC24

Writing Toolsの導入 アプリにおいてユーザーによるテキストの校正、書き直し、変換をサポートするWriting Tools(作文ツール)の機能をご紹介します。いずれかのテキストビューで記述したテキストをユーザーがブラッシュアップできるようにするため、Writing Toolsとアプリがどのように連携するかについて詳しく解説します。テキストの取得および処理の仕組みや、カスタムのテキストビューでWriting Toolsをサポートする方法を習得できます。 nsservices,nstextview,textkit,uitextview,wkwebview WWDC24

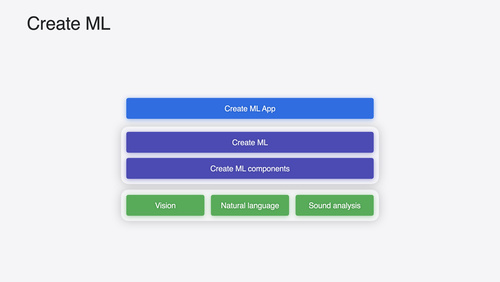

Create MLの新機能

WWDC24

Create MLの新機能 インタラクティブなデータソースのプレビュー、visionOSアプリ向けオブジェクトトラッキングモデルの構築で使用する新しいテンプレートなど、Create MLの新機能をご紹介します。新しい時系列予測や分類のAPIなど、フレームワークの重要な機能強化についても取り上げます。 create ml,create ml framework,machine learning WWDC24

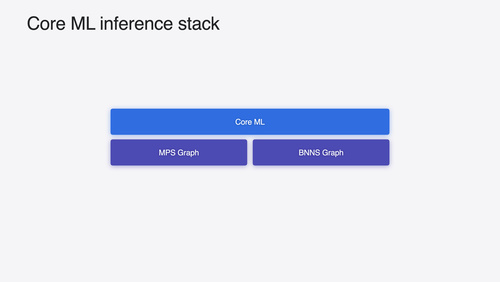

Core MLを使用してデバイス上に機械学習モデルとAIモデルをデプロイ

WWDC24

Core MLを使用してデバイス上に機械学習モデルとAIモデルをデプロイ Core MLによって機械学習モデルとAIモデルを変換し実行する際のスピードとメモリパフォーマンスを最適化する、新しい方法を確認しましょう。モデルの表現、パフォーマンスに関するインサイトの取得、実行、モデルのスティッチングのための新しいオプションについて解説します。これらのオプションを組み合わせることで、デバイス上のプライベートな環境で効果的な体験を実現できます。 ai,coreml,coreml editor,machine learning WWDC24

visionOSにおけるオブジェクトトラッキングの詳細

WWDC24

visionOSにおけるオブジェクトトラッキングの詳細 実世界のオブジェクトをvisionOSアプリ内の仮想アンカーに変換する、オブジェクトトラッキングの使用方法を説明します。オブジェクトトラッキングを使用して空間体験を構築するプロセスの全体を学ぶことができます。Create MLでの機械学習を使用して参照オブジェクトを作成し、Reality Composer Pro、RealityKit、ARKit APIのターゲットオブジェクトに関連するコンテンツをアタッチする方法もご紹介します。 WWDC24

DockKitの新機能

WWDC24

DockKitの新機能 被写体間のスムーズな切り替えを可能にする、DockKitのインテリジェントトラッキングについて説明します。インテリジェントトラッキングとは何か、インテリジェントトラッキングがMLモデルを使用して被写体を選択し、トラッキングする仕組み、この機能をアプリに取り入れる方法をご紹介します。 camera,dock,intelligence,machine learning,object detection WWDC24

VisionフレームワークにおけるSwiftの機能強化

WWDC24

VisionフレームワークにおけるSwiftの機能強化 並列処理など、新しいSwift機能を利用できるようにVision Framework APIが刷新され、さまざまなVisionアルゴリズムをより簡単に、より迅速にアプリに統合できるようになりました。新しくなったVision Framework APIの内容を確認し、さらにサンプルコードとベストプラクティスをご紹介します。最小限のコーディングでこのフレームワークのメリットを得る方法を学びましょう。2つの新しい機能(画像の審美的評価と全身のポーズ)のデモも行います。 machine learning amp vision WWDC24

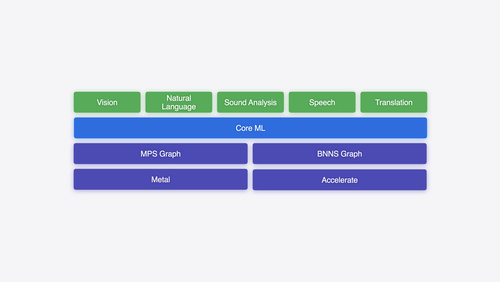

Appleプラットフォームでの機械学習の詳細

WWDC24

Appleプラットフォームでの機械学習の詳細 Appleプラットフォームにおける機械学習フレームワークについて概説します。MLモデルを初めて実装する場合でも、すでにMLに精通している場合でも、アプリのニーズを満たす適切なフレームワークを選択する際に役立つ情報が得られます。 ai,bnns,machine learning amp vision,metal,mps,mps graph,pytorch WWDC24

Core Spotlightによるセマンティック検索のサポート

WWDC24

Core Spotlightによるセマンティック検索のサポート Core Spotlightを使用して、アプリにセマンティック検索の結果を表示する方法をご紹介します。ユーザーのデバイス上のプライベートインデックス内でアプリのコンテンツを参照可能にして、ユーザーが自然言語で項目を検索できるようにする方法を学べます。また、インデックス作成アクティビティのスケジュールを設定して、アプリのパフォーマンスを最適化する方法も説明します。 このセッションの内容を最大限に活用するには、まずApple Developer WebサイトにあるCore Spotlightのドキュメントを確認されることをお勧めします。 ,cssearchableindex,cssearchableitem,cssearchableitemattributeset,csuserquery WWDC24

すべてのキャプチャで色の一貫性を維持

WWDC24

すべてのキャプチャで色の一貫性を維持 Constant Color APIの概要と、正確な色を判断するための機能をアプリで提供するうえでこのAPIがどのように役立つかをご紹介します。APIの導入方法、このAPIが科学およびマーケティングの領域にもたらす可能性、この技術を最大限に活用するためのベストプラクティスを学ぶことができます。 camera,color,colorspace,machine learning,photos WWDC24

システムの利便性を高めるApp Intentのデザイン

WWDC24

システムの利便性を高めるApp Intentのデザイン App Intentは、コントロール、Spotlight、Siriなどでのシステム体験を向上させます。このセッションでは、App Intentに最も適した機能を特定する方法や、パラメータを使用してこれらのインテントの柔軟性を高める方法を説明します。App Intentを使用して、ユーザーがアプリの外側でアクションを実行できるようにする方法も取り上げます。さらに、アプリにナビゲートしてコンテキスト情報を表示するタイミングについても、実例を交えてご紹介します。 WWDC24

Apple GPUでの機械学習モデルとAIモデルのトレーニング

WWDC24

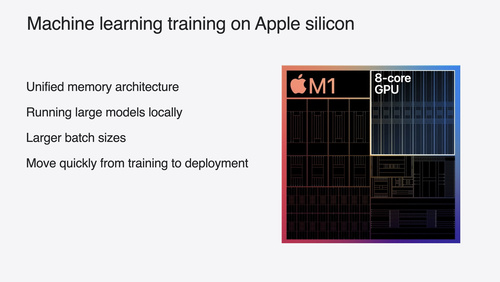

Apple GPUでの機械学習モデルとAIモデルのトレーニング PyTorch、JAX、TensorFlow向けのMetalを使用し、Appleシリコンでモデルをトレーニングする方法を解説します。新しいアテンション操作と量子化のサポートを利用して、デバイス上でのTransformerモデルのパフォーマンスを向上させましょう。 ai,gpu,machine learning,metal,pytorch WWDC24

HDRを使用してアプリのダイナミックイメージ体験を向上

WWDC24

HDRを使用してアプリのダイナミックイメージ体験を向上 HDR画像を読み書きする方法、およびアプリでHDRコンテンツを処理する方法について説明します。新たにサポートされたHDR画像形式と、HDR画像を表示するための高度な方法を確認しましょう。HDRコンテンツをユーザーインターフェイスと共存させる方法に加え、HDR画像のサポートをアプリに追加する際の注意事項も取り上げます。 adaptive,camera,hdr,photokit,photos WWDC24

visionOS向けエンタープライズAPIのご紹介

WWDC24

visionOS向けエンタープライズAPIのご紹介 visionOS向けの新しいエンタープライズAPIを使用して、Apple Vision Proで従業員やユーザーの生産性を高める空間体験を創出する方法を学びましょう。 WWDC24

Translation APIについて

WWDC24

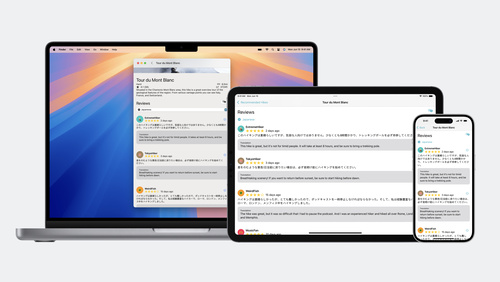

Translation APIについて 新しいTranslationフレームワークを使用して、アプリにおいて複数の言語間でテキストを翻訳する方法を解説します。 システムUIに迅速に翻訳を表示する方法や、アプリUIのテキストの大規模なバッチを翻訳する方法を習得できます。 language,language detection,machine learning,text analysis WWDC24

アプリをSiri対応にするための方法

WWDC24

アプリをSiri対応にするための方法 App Intentを利用して、Siriとアプリの機能を連携させる方法をご紹介します。現在利用可能な既存のインテントを確認した後、カスタムインテントを作成して、アプリからのアクションをシステムに統合する方法を説明します。提供するメタデータの種類、Spotlightを使用してエンティティを検索可能にする方法、画面上に注釈を追加する方法なども取り上げます。 ai,app intents,machine learning,siri,siri intents editor WWDC24

ロック画面での優れたカメラキャプチャ体験の構築

WWDC24

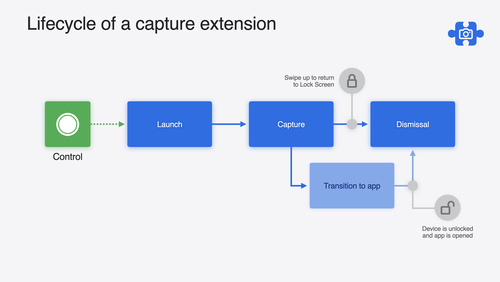

ロック画面での優れたカメラキャプチャ体験の構築 LockedCameraCapture APIにより、キャプチャアプリの最も有用な情報をロック画面に直接取り込む方法について説明します。このAPIの機能を確認した後、キャプチャ拡張機能の作成を開始する方法をご紹介します。さらに、デバイスがロックされているとき、キャプチャ拡張機能がどのように動作するかについても解説します。 camera,lock screen,machine learning WWDC24

App Intentでアプリのコア機能をユーザーに提供

WWDC24

App Intentでアプリのコア機能をユーザーに提供 インテント、エンティティ、クエリなど、App Intentフレームワークの原則について解説するとともに、これらを利用して、アプリの最も重要な機能をユーザーが最も必要としている場面で提示する方法を説明します。Siri、コントロールとウィジェット、Apple Pencil、ショートカット、アクションボタンなど、App Intent上に構築された多数のシステム機能とアプリを密に統合する方法を確認しましょう。App Intentを効率的に統合し、コードとコア機能を共有しつつ、あらゆるディスプレイで最適な体験を作成するためのヒントもご紹介します。 app intents,machine learning WWDC24

App Intentの新機能

WWDC24

App Intentの新機能 App Intentの改善点と強化点をご紹介し、アプリの機能をSiriやその他の新しい機能と連携させるうえで、このフレームワークがどのように役立つかを説明します。Transferable API、File Representations、Item Providers、Spotlight Indexingを使用してAppleプラットフォームでのエンティティの有用性を高め、Siriやショートカットアプリでパワフルな機能を利用できるようにする方法をご紹介します。URL Representable Entitiesと柔軟なScene... app intents,machine learning WWDC24

機械学習とAIモデルをAppleシリコンに統合

WWDC24

機械学習とAIモデルをAppleシリコンに統合 Appleシリコンのパワーを活用できるように、機械学習モデルとAIモデルを最適化する方法をご紹介します。これらのモデルを変換し、デバイスへのデプロイに向けた準備のワークフローについて解説します。また、Appleシリコンと互換性があるモデル圧縮の方法と、モデルデプロイワークフローのどの段階で実施するかについて説明します。ストレージサイズ、遅延、電力消費、正確性の間のトレードオフも取り上げます。 ai,compression,machine learning,metal,mps graph,optimization,silicon WWDC24

Metalによる機械学習の加速

WWDC24

Metalによる機械学習の加速 Metal Performance Shaders Graphの新しい機能を使用して、機械学習のTransformerモデルを加速する方法を説明します。モデルのコンピューティングの帯域幅と質を向上させ、それをまったく新しいMPSGraphビューアに表示する方法も取り上げます。 machine learning,metal,metal compute WWDC24

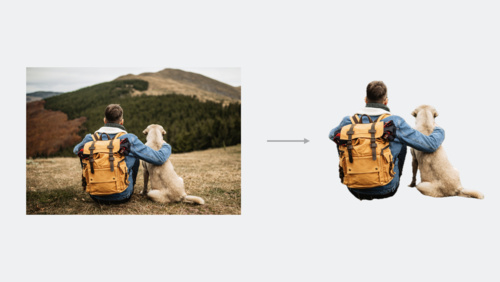

アプリ内の画像からの被写体の切り抜き

WWDC23

アプリ内の画像からの被写体の切り抜き アプリで、画像の背景から被写体を簡単に切り抜く方法を紹介します。VisionKitを使用して、メインの被写体を切り抜いたり、指定したポイントで被写体にアクセスする方法を学びます。また、Visionを使用して被写体を切り抜き、Core Imageのような下位レベルのフレームワークと組み合わせて、楽しい画像エフェクトやより複雑な合成パイプラインを作成する方法も紹介します。 VisionKitの最新アップデートについては、「What's new in VisionKit」を、画像内の人物セグメンテーションについてはWWDC23の 「Explore 3D body pose and person... WWDC23

Visionで動物のポーズを検出

WWDC23

Visionで動物のポーズを検出 Visionを使用して、画像から犬や猫を検出するだけではなく、これらの動物の個々の関節やポーズをすべてリアルタイムで検出する方法を紹介します。また、カメラアプリでの動物のトラッキングや、動物の写真を使ったクリエイティブな装飾方法など、エキサイティングな新機能を有効にする方法を紹介します。さらに、Visionのその他の重要な改良点とベストプラクティスも紹介します。Visionフレームワークの新機能についての詳細は、「Explore 3D body pose and person segmentation in Vision」や「Lift subjects from images in... WWDC23

Create MLにおける機械学習強化

WWDC23

Create MLにおける機械学習強化 Create MLを使えば、機械学習モデルで可能な事がさらに広がります。多言語のBERT埋め込みを使った画像理解やテキストベースのタスクに、最新のアップデートが加えられました。マルチラベル分類を使って画像のコンテンツを理解できるよう、容易にモデルをトレーニングする方法をご紹介します。また、インタラクティブモデル評価や、カスタムトレーニングデータオーグメンテーション用の最新のAPIについての情報も説明します。機械学習の詳細についての最新アップデートは、WWDC23の「Explore Natural Language multilingual models」および「Improve Core... WWDC23

VisionKitの新機能

WWDC23

VisionKitの新機能 VisionKitを使用することで、アプリ内の画像から被写体をすばやく浮き上がらせ、Visual Look Upで画像の内容を詳しく把握する方法を紹介します。また、Live Textインタラクション、データスキャン、macOSアプリの拡張サポートなど、VisionKitの最新アップデートについても紹介します。VisionKitの詳細については、WWDC23の「Lift subjects from images in your app」をご覧ください。 WWDC23

マルチリンガルな自然言語モデルの紹介

WWDC23

マルチリンガルな自然言語モデルの紹介 マルチリンガルなTransformerベースの埋め込みを使用して、カスタム自然言語モデルを作成し、テキスト分類や、単語のタグ付けに役立てましょう。少ないデータでトレーニングを行い、3つのスクリプトで最大27の言語をサポートする方法を紹介します。これらの埋め込みを使用して、PyTorchやTensorFlowでトレーニングした複雑なモデルを微調整する方法を紹介します。自然言語の詳細については、WWDC20の「Make apps smarter with Natural Language」をご覧ください。 WWDC23

Visionの3Dボディーポーズと人物セグメンテーションの詳細

WWDC23

Visionの3Dボディーポーズと人物セグメンテーションの詳細 Visionで人物を中心とした機能を構築する方法をご確認ください。人体のポーズを検出し、3D空間で個々の関節の位置を測定する方法を紹介します。また、人物のセグメンテーションAPIを活用して、画像内の最大4人の人物を区別してセグメンテーションする方法も紹介します。 Visionの最新機能については、WWDC23の「Visionで動物のポーズを検出」をご確認ください。 WWDC23

Metalアプリにおける機械学習の最適化

WWDC23

Metalアプリにおける機械学習の最適化 Metalにおける、高速なMLトレーニング方法に関する最新の機能強化について解説します。PyTorchとTensorFlowのアップデート情報、JAXのMetalアクセラレーションについて紹介します。GPUとApple Neural Engineの両方を使用する際に、MPG GraphがML推論を高速化をサポートする仕組みについてや、同じAPIを使用してCore MLとONNXモデルを迅速に統合する方法について解説します。Metalを使った機械学習の詳細については、WWDC22の「Accelerate machine learning with Metal」をご覧ください。 WWDC23

非同期予測によるCore ML統合の改善方法

WWDC23

非同期予測によるCore ML統合の改善方法 Core ML実行エンジンの最新の改善点を活用してアプリの機械学習機能を高速化する方法を学びましょう。推論とモデルの高速な読み込みに役立つ、積極的なアセットのキャッシングの活用方法を紹介します。応答性の高いアプリを作成するために、最新の非同期予測のオプションや、パフォーマンスと全体的なメモリ使用量のバランスを考慮する方法を紹介します。モデルのハードウェア稼働率を理解し、その最大化に役立つAPIを紹介します。Core MLモデルの使用を最適化する方法については、WWDC23の「Use Core ML Tools for machine learning model... WWDC23

Core ML Toolsを使った機械学習モデルの圧縮法

WWDC23

Core ML Toolsを使った機械学習モデルの圧縮法 Core ML Toolsを使って、アプリ内の機械学習モデルのフットプリントを削減する方法を紹介します。パレット化、プルーニング(刈り込み)、量子化などのテクニックを使用して、モデルのサイズを劇的に圧縮しつつ、優れた精度を実現する方法を紹介します。トレーニング段階での圧縮と、完全にトレーニングされたモデルでの圧縮を比較し、Apple Neural Engineを最大限に活用することで、圧縮されたモデルをさらに高速に実行する方法を学びます。Core MLの最適化については、WWDC23の「Improve Core ML integration with async... WWDC23

DockKitを利用した電動iPhoneスタンドとの統合

WWDC23

DockKitを利用した電動iPhoneスタンドとの統合 DockKitと互換性がある電動スタンドと統合して、カメラアプリで素晴らしい写真やビデオの体験を作成する方法を紹介します。 アプリが360度の視野全体でライブビデオ内の被写体を自動的にトラッキングし、スタンドを直接制御してフレーミングをカスタマイズしたり、モーターを直接制御したり、他のオブジェクトのトラッキングのための独自の推論モデルを提供したりする方法を説明します。 最後に、動的なデバイスアニメーションを通じて感情を演出する方法も紹介します。 画像トラッキング技術の詳細については、WWDC23の「Visionで動物のポーズを検出」および WWDC21 の「Create... WWDC23

デバイス上の音声認識のカスタマイズ

WWDC23

デバイス上の音声認識のカスタマイズ 語彙を追加し基礎モデルをカスタマイズすることで、アプリのデバイス上音声認識を向上させる方法を紹介します。音声認識がデバイス上でどのように動作し、より予測可能な転写(トランスクリプション)のために特定の言葉やフレーズをどうしたら促進できるのか説明します。すべてランタイムで言葉の特定の発音を提供し、カスタムフレーズのフルセットを素早く生成できるテンプレートサポートを利用する方法について確認しましょう。スピーチフレームワークついて、詳しくはWWDC19の「Advances in Speech Recognition」をご参照ください。 WWDC23

Create MLの最新情報

WWDC22

Create MLの最新情報 Create MLの最新情報をご覧ください。Create MLの評価ツールの改善点について解説します。これで、ご利用のカスタムモデルがリアルワールドデータで機能する仕組みを把握できるようになります。さらに、テストデータにおける各種画像のモデルパフォーマンスをチェックしたり、個々の画像の問題を特定して、分類ミス、データの不適切なラベル付け、その他のエラーのトラブルシューティングを実施したりする方法について解説します。また、Continuity Cameraでのライブプレビューで、iPhoneやiPadを使用してご利用のモデルをテストする方法をはじめ、Create ML... WWDC22

Create ML Componentsについて学ぶ

WWDC22

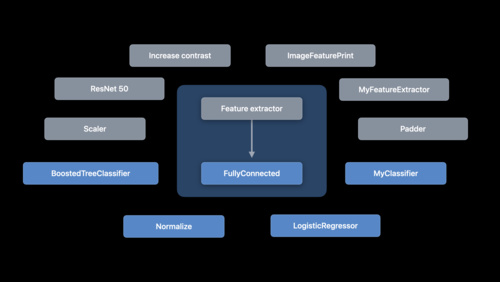

Create ML Componentsについて学ぶ Create MLにより、画像識別、オブジェクト検出、音声識別、ハンドポーズ識別、アクション識別、形式データの回帰などのカスタム機械学習モデルが簡単に構築できるようになります。また、Create ML Componentsフレームワークを使用すると、基礎となるタスクをさらにカスタマイズして、モデルを改良できるようになります。これらのタスクを構成する特徴抽出器、トランスフォーマー、エスティメーターについて解説し、これらを他のコンポーネントや前処理行程と組み合わせて、画像回帰などのコンセプトのカスタムタスクを構築する方法を紹介します。... WWDC22

VisionKitで機械可読コードやテキストをキャプチャする

WWDC22

VisionKitで機械可読コードやテキストをキャプチャする VisionKitのData Scannerとは:このフレームワークは、AVCaptureとVisionを組み合わせて、シンプルなSwift APIで機械可読コードやテキストをライブキャプチャできるようにするものです。ここでは、バーコードの種類や言語選択を指定して、Appがキャプチャできるコンテンツの種類を制御する方法を紹介します。また、Appのガイダンスを有効化したり、項目のハイライト表示や関心領域をカスタマイズしたり、Appで項目が検出されたときにインタラクションを処理したりする方法も紹介します。 静止画または一時停止したビデオフレームでのLive... WWDC22

Core MLの使用を最適化する

WWDC22

Core MLの使用を最適化する Core MLが、CPU、GPU、ニューラルエンジンと連携して、オンデバイスでプライバシーを保護する機械学習エクスペリエンスをAppに促す仕組みについて解説します。さらに、最新ツールについても解説するので、ご利用のモデルのパフォーマンスを把握し、最大限に活用することができるようになります。また、ご利用のモデルのパフォーマンス特性を簡単に把握できるレポートの生成方法も紹介するので、Core ML Instrumentでご利用のモデルに対するインサイトも得られるようになります。さらに、APIを強化して、AppとのCore ML統合を最適化しますのでご覧ください。... WWDC22

Create ML Componentsで高度なモデルを作成する

WWDC22

Create ML Componentsで高度なモデルを作成する Create ML Componentsで、カスタム機械学習モデルを次のレベルに引き上げます。動画やオーディオなどの時間データの操作方法をはじめ、人の反復動作をカウントしたり、高度な音声分類を提供するモデルの作成方法を紹介します。また、インクリメンタルな調整で、新しいデータを使用したモデルトレーニングを迅速化するベストプラクティスも紹介します。 カスタム機械学習モデルの導入については、WWDC22の「Create ML Componentsについて学ぶ」をご覧ください。 WWDC22

Visionの最新情報

WWDC22

Visionの最新情報 テキストの認識・顔や顔のパーツの位置検出・オプティカルフローの実装など、Vision APIの最新情報をご覧ください。ビデオベースのAppのためのオプティカルフロー機能について紹介し、これらのAPIを駆動する機械学習モデルのリビジョンに合わせてAppを更新したり、XcodeのQuick Look PreviewサポートでVisionタスクを視覚化する方法を紹介します。 このセッションを最大限に活用するには、WWDC21の「Visionによる人物、顔、ポーズの検出」をご覧ください。 WWDC22

Metalで機械学習を加速する

WWDC22

Metalで機械学習を加速する Metalを使用して、macOSでのPyTorchモデルトレーニングを加速する方法をご覧ください。TensorFlowトレーニングサポートの最新情報をはじめ、MPS Graphの最新機能や操作、優れたパフォーマンスで機械学習のあらゆるニーズに対応するベストプラクティスを紹介します。 機械学習でのMetalの使用について、詳しくはWWDC21の「Metal Performance Shaders Graphによる機械学習の加速」をご覧ください。 WWDC22

機械学習を組み込んだAppの開発手法

WWDC22

機械学習を組み込んだAppの開発手法 優れた機械学習(ML)によるエクスペリエンスをあなたのAppに取り入れる方法を紹介します。モデルの発見、変換、トレーニングについて解説し、MLのヒントとベストプラクティスを紹介します。さらに、MLの導入に伴う考慮すべき事項をはじめ、モデルのパフォーマンスを評価するテクニックや、モデルを調整して、デバイスでリアルタイムのパフォーマンスを実現する方法について解説します。 このセッションで取り上げたテクニックの詳細については、WWDC22の「Core MLの使用を最適化する」および「Metal Performance Shaders Graphで機械学習を促進する」をご覧ください。 WWDC22

Create MLの物体検出モデルの改善

Tech Talks

Create MLの物体検出モデルの改善 Create MLで物体検出のカスタムCore MLモデルをトレーニングする際、Appに画像を理解させることができます。

転移学習による、少ない学習データでより小さなモデルを構築する方法を理解しましょう。更にCreate MLの進化したパラメータによって、インプットする画像のトレーニングイテレーション、バッチサイズ、グリッドの寸法をコントロールでき、モデルの精度に関して十分な管理が可能になります。

物体検出の入門編については、WWDC19の"Training Object Detection Models in Create ML"をご覧になってください。 ai,computer vision,core ml,create ml,machine learning,object detection,vision Tech Talks

TabularDataを使ったSwiftでのデータの分析と操作

Tech Talks

TabularDataを使ったSwiftでのデータの分析と操作 TabularDataフレームワークを使って、Swiftで非構造化データの読み込み、分析、操作を行う方法を確認します。この方法は、機械学習タスクのためにデータを事前に処理する必要がある場合や、Appでデータをオンザフライで処理する必要がある場合に利用できます。大規模なデータセットを扱う場合、複数のデータテーブルを統合する場合、データをプログラムでフィルタリングする場合に、TabularDataフレームワークがどのように役立つかを説明します。また、DataFrameを活用して、Appのデータ処理を中心とした機能を実行する方法についても紹介します。 Tech Talks

PyTorchモデルをCore MLに変換する

Tech Talks

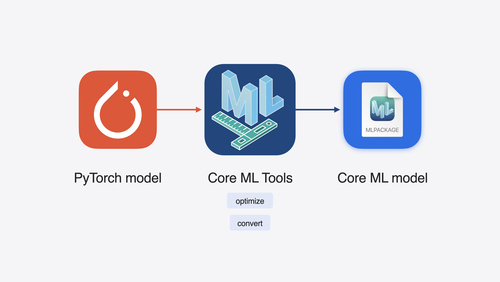

PyTorchモデルをCore MLに変換する PyTorchモデルをCore MLへ変換して、オンデバイスの機械学習をAppで活用する方法を理解しましょう。

PyTorchの機械学習のフレームワークは、複素ニューラルネットワークの作成やトレーニングを手助けします。モデルを構築した後にCore MLへと変換し、完全にオンデバイスで動かすことができ、CPUやGPU、ニューラルエンジンを最大限に活用できます。

Core ML ToolsパッケージがTorchScriptモデルを直接、変換させる方法を理解し、カスタマイズ操作と発生する変換エラーの扱いについて学びましょう。

Core... ai,artificial intelligence,core ml,core ml tools,deep learning,learning,machine learning,model,natural language,neural network,python,pytorch,training Tech Talks

インクルーシブなデザインのプロセス

WWDC21

インクルーシブなデザインのプロセス ソフトウェアを使用するすべての人に素晴らしい体験を提供できるような、インクルーシブなAppを提供する方法を紹介します。また、多様なチームを結成してその能力を強化するためのベストプラクティスを紹介します。インクルーシブな考え方が、デザインと開発プロセスの各段階にどう影響するかを確認しましょう。 WWDC21

見つけやすいデザイン

WWDC21

見つけやすいデザイン インタラクティブで記憶に残る体験を作って人々をAppに引き込む方法を紹介します。ここでは、見つけやすいデザインの手法を紹介して、一目でAppの可能性を把握できる、探索可能で楽しいインターフェイスを作る方法を確認します。また、この手法を応用してコンテンツをパーソナライズして、Appを簡単にカスタマイズする方法も紹介します。 ,,discoverability,menus,navigation,onboarding WWDC21

SoundAnalysisのビルトイン音声識別

WWDC21

SoundAnalysisのビルトイン音声識別 Sound AnalysisフレームワークをAppで使用すると、マイクからのライブサウンド、ビデオやオーディオファイルなど、あらゆるオーディオソースからの個別の音を検出・識別し、その音が発生した瞬間を正確に特定できます。ビルトインの音声識別機能を使えば、カスタムのトレーニングモデルがなくても、300種類以上の音を簡単に識別できます。人の声、楽器の音、動物の声、様々なアイテムの音など、いろいろな音を識別できます。 カスタムモデルについては、Audio Feature... audio,core ml,create ml,create ml framework,machine learning,sound,sound analysis WWDC21

Visionによる人物、顔、ポーズの検出

WWDC21

Visionによる人物、顔、ポーズの検出 Visionフレームワークの最新のアップデートにより、Appで人、顔、ポーズを検出できるようになりました。画像内の人物を周囲の環境から分離するためのPerson Segmentation APIや、人物の頭部のピッチ、ヨー、ロールを追跡するための最新のコンティグメトリクスを紹介します。また、こうした機能をCore Imageなどの他のAPIと組み合わせることで、シンプルなバーチャル背景から、画像編集Appでのリッチなオフライン合成まで、さまざまな機能を実現することができます。... ai,body pose,computer vision,core ml,face capture quality,face detection,face landmarks,hand pose,machine learning,person segmentation,segmentation,vision WWDC21

Create MLによる手のポーズや動作の識別

WWDC21

Create MLによる手のポーズや動作の識別 Create MLを使えば、人間の手の表現力をAppで理解することがこれまで以上に簡単になります。Create ML Appとフレームワークを使って、Visionによる手のポーズ検出のサポートをベースに、カスタムの手のポーズと手の動作の識別モデルをトレーニングする方法を紹介します。データの収集、モデルの学習、そしてVision、Camera、ARKitとのインテグレーションがいかに簡単にできるかを確認し、楽しくて面白いApp体験を創り出しましょう。 Create MLの詳細やモデルのトレーニングに関するコンセプトについては、WWDC20の「Create... ai,body pose,core ml,create ml,fitness,hand action classification,hand pose,hand pose classification,machine learning,vision WWDC21

Create MLフレームワークを使ったダイナミックなiOS Appの構築

WWDC21

Create MLフレームワークを使ったダイナミックなiOS Appの構築 Create MLフレームワークを使って、Core MLモデルを完全にデバイス上でトレーニングすることで、データのプライバシーを守りながら、適応性の高いカスタマイズされたAppエクスペリエンスを実現する方法を紹介します。スタイル変換や画像識別といった画像ベースのタスク、カスタム音声識別などのオーディオタスク、またはテキスト識別、表形式データの識別、および表形式データの回帰分析などのタスクといった、オンザフライ方式で作成できるモデルタイプについて確認します。また、Appをよりパーソナルでダイナミックなものにするため、これらのモデルから提供される多数の可能性を紹介します。... ai,core ml,create ml,create ml framework,machine learning,ondevice training WWDC21

Visionによるドキュメントデータの抽出

WWDC21

Visionによるドキュメントデータの抽出 Visionを使用して、アプリ内で専門的な画像認識・分析を行い、ドキュメントから情報を抽出したり、多言語のテキストを認識したり、バーコードを識別したりする方法を紹介します。本セッションでは、テキスト認識とバーコード検出の最新のアップデートについて紹介し、これらのツールをCore MLと組み合わせて、画像やライブカメラを通してアプリが環境をより理解できるようにする方法について説明します。Visionによって提供されている機能をさらに理解するには、WWDC21の「Visionによる人物、顔、ポーズの検出」とWWDC20の「Computer Vision APIの探求」をご確認ください。 barcode,barcode detection,computer vision,core ml,machine learning,ocr,text recognition,vision WWDC21

Accelerateを使用したパフォーマンス改善と暗号化アーカイブの組み込み

WWDC21

Accelerateを使用したパフォーマンス改善と暗号化アーカイブの組み込み Accelerateフレームワークを使用すると、大規模な数学計算やイメージ計算を少ない消費電力で高速に行うことができます。AccelerateとそのBasic Neural Network Subroutinesライブラリの最新のアップデート内容を検証します。これには、追加のレイヤー、アクティベーション関数、向上したオプティマイザサポートが含まれます。C++テンプレートのサポートを強化したsimd.hの改良点をご確認ください。Apple Encrypted Archiveは、Apple... accelerate,apple archive,archives,bnns,encryption,numerics,performance,simd,vector,vectorization WWDC21

Core MLモデルのチューニング

WWDC21

Core MLモデルのチューニング Core MLによって、機械学習のパワーを直接Appに取り込むことができます。CPU、GPU、Neural Engineをどのように活用すれば、デバイスから離れることなく、プライバシーを保護しながら、最大限のパフォーマンスを発揮できるかを紹介します。Swiftで多次元データを簡単に扱うことができるMLShapedArray、Core MLのML ProgramsをサポートしたML Packageについて詳しく説明します。機械学習に対するこの最新のプログラム的なアプローチは、型指定された実行を可能にして、驚異的な柔軟性を提供します。また、モデルのパフォーマンスを分析する方法や、ML... ai,core ml,core ml converters,core ml tools,machine learning,neural network,neural networks,python WWDC21

Metal Performance Shaders Graphによる機械学習の加速

WWDC21

Metal Performance Shaders Graphによる機械学習の加速 Metal Performance Shaders Graphは、線形代数、機械学習、コンピュータビジョン、および画像処理のためのカスタマイズされた多次元グラフをビルド、コンパイル、および実行するのに役立つ計算エンジンです。Apple製品のMetalバックエンドを通じて、MPSGraphが人気のTensorFlowプラットフォームをいかにして加速できるかについて紹介します。グラフに制御フローを加えたり、グラフのコンパイルを管理してパフォーマンスを最適化したり、MPSGraphオペレーションを使用してわずか数行のコードで最もハードな演算アプリケーションを高速化する方法を確認します。 machine learning,metal,metal shading language,optimization,performance WWDC21

Create MLを使用したアクションクラシファイアの構築

WWDC20

Create MLを使用したアクションクラシファイアの構築 Create MLでAction Classificationモデルを作成する方法を説明します。カスタムアクションクラシファイアを使用すると、Appはビデオまたはカメラを介してリアルタイムで身体の動きを認識し、理解することができます。ジャンピングジャック、スクワット、ダンスの動きなどの人間の動作を識別するために、サンプルを使用してCore MLモデルを容易にトレーニングする方法についてご説明します。これを支えるVision FrameworkのBody... action classification,action classifier,activity classification,ai,body pose,core ml,create ml,fitness,machine learning WWDC20

Core MLでのモデルの配布とセキュリティ

WWDC20

Core MLでのモデルの配布とセキュリティ Appのバイナリ外でCore MLモデルをデプロイし、機械学習機能をAppに導入する際により柔軟で制御しやすくする方法について説明します。また、Core MLモデルデプロイメントによりAppのアップデートを行うことなく更新されたモデルを導入する方法についても学習します。さらに、暗号化を使用してカスタムの機械学習モデルを保護する方法や、Xcodeでモデルのパフォーマンスをプレビューする方法も一通り説明します。

TensorFlowやPyTorchなどの環境で学習済みのモデルを取り込む場合など、Core MLの使い方の詳細については、"Get your models on device... ai,artificial intelligence,cloud,cloudkit,core ml,core ml tools,create ml,deep learning,encryption,learning,machine learning,model,model deployment,model encryption,neural network WWDC20

Visionで身体や手のポーズを検出する

WWDC20

Visionで身体や手のポーズを検出する Visionフレームワークを使い、あなたのAppで写真や動画内の身体や手のポーズをどう検出することができるかを説明します。ポーズ検出を使えば、Appが人のポーズ、動き、ジェスチャーを分析し、新たな動画編集の可能性が提供でき、Create MLにビルトインの action classifierと組み合わせることで動作識別も実行できるようになります。手のポーズからApp内でのジェスチャー認識を可能にし、まったく新たな形式の相互作用を届ける方法もお伝えします。

動作識別で身体のポーズを応用する方法をより深く理解するため、 "Build an Action Classifier with... action classification,action classifier,bean bag toss,body pose,camera,cornhole,gesture,hand pose,machine learning,photo,pose estimation,ui control,video,vision WWDC20

Action & Vision Appの探求

WWDC20

Action & Vision Appの探求 今では、機械学習を活用したフィットネスやスポーツコーチング向けのAppを簡単に作れるようになりました。それを証明するために、当社は独自のAppを作りました。Visionフレームワークにおける新しい体勢推定(Body Pose Estimation)、軌跡検出(Trajectory Detection)、および輪郭検出(Contour Detection)に加え、Create MLでObject DetectionとAction Classificationを使用してAction & Vision... action class,bean bag toss,body pose,camera,contour,core ml,cornhole,create ml,machine learning,object detection,trajectory,vision WWDC20

Computer Vision APIの探求

WWDC20

Computer Vision APIの探求 Core Image、Vision、およびCore MLを組み合わせることで、AppにComputer Vision のインテリジェンスを導入する方法について学びます。機械学習だけにとどまらず、画像や動画の理解を深めましょう。Core ImageおよびVisionにおける新しいAPIを見つけ、新しいしきい値フィルター、輪郭検出(Contour Detection)、フレーム間予測(Optical Flow)などのAppにComputer Visionを取り入れます。また、Core Imageを使用して、これらの結果の前処理と可視化を行う方法を検討します。... cifilter,ci filters,ciimage,cikernel,computer vision,contour,core image,core ml,machine learning,optical flow,trajectory,vision,visualization WWDC20

Natural LanguageでAppをよりスマートに

WWDC20

Natural LanguageでAppをよりスマートに Natural Languageフレームワークを活用し、テキストをより良く分析、理解する方法を学びましょう。フレームワークにビルトインの埋め込み単語や文章を使い、テキストから意味を引き出す方法、また特定の要件に向けたカスタマイズの埋め込みを作る方法もお見せします。

カスタムテキストクラシファイアのトレーニングにサンプルを用いること、重要な一片の情報をテキストからワードタガーを用いて抽出すること、これらすべてをNatural... core ml,create ml,custom models,embeddings,machine learning,natural language,nlp,sentence embedding,text analysis,text processing,word embedding,word tagging WWDC20

Create MLにおけるImage and Video Style Transferモデルの作成

WWDC20

Create MLにおけるImage and Video Style Transferモデルの作成 Create MLのStyle Transferを使用して、写真や動画にスタイル付けされたエフェクトを導入します。モデルを数分でトレーニングして、クリエイティブなビジュアル機能をAppに簡単に導入できる方法を紹介します。トレーニングのプロセスと、結果を制御するためのオプションについて学びます。また、これらのモデルの内3つを同時にARKitでデモンストレーションすることによって、リアルタイムのパフォーマンスを確認します。

本セッションの前に、Create MLを使いこなせるようになっておくことをお勧めします。概要については、“Introducing the Create ML... ai,core ml,create ml,neural network,photo,photo effects,style density,style strength,style transfer,video,video effects WWDC20

Swiftを使用したCreate MLでのトレーニング管理

WWDC20

Swiftを使用したCreate MLでのトレーニング管理 Create MLフレームワークを使用することで、これまで以上にモデルを簡単に開発し、ワークフローを自動化できます。ここでは、より良いモデルを素早く得るために、機械学習モデルをトレーニングしながら、機械学習モデルを管理する方法について説明します。Create MLにおけるトレーニング管理によって、チェックポイントAPIを使用してトレーニングワークフローをカスタマイズして、トレーニングプロセスを一時停止、保存、再開、および拡張する方法を紹介します。また、Combine APIを使用して、プログラムで進捗をモニターする方法についても学びます。

まだCreate... checkpointing,checkpoints,combine,core ml,create ml,iterations,ml job,ml session,playgrounds,swift WWDC20

Metal Performance Shaders GraphでカスタムMLモデルを構築する

WWDC20

Metal Performance Shaders GraphでカスタムMLモデルを構築する MetalのCompute能力をマルチディメンションTensorsに拡張する、Metal Performance Shaders (MPS) Graphをご紹介します。MPS Graphは高度にチューニングされた並列処理データライブラリの上に構築され、機械学習に欠かせないものであり、多大なGPUパワーを活用します。MPS Graphにより洗練された、ダイナミックなニューラルネットワーク学習のアーキテクチャを表現する方法、またアーキテクチャ上でGPUを加速させるための最適化の仕方をお伝えします。

このセッションで網羅するコンセプトをより深く理解するには、WWDC19の"Metal for... compute,graph,machine learning,metal,metal shading language,mps,mps graph,neural network,operations,tensors WWDC20

Core ML Convertersを使用したデバイス上のモデルの取得

WWDC20

Core ML Convertersを使用したデバイス上のモデルの取得 Core MLでは、驚くような機械学習モデルをAppに持ち込み、完全にデバイス上で実行することができます。また、Core ML Convertersを使用すると、TensorFlowまたはPyTorchのトレーニングを受けたモデルのほとんどを組み込み、GPU、CPU、およびNeural Engineを最大限に活用できます。既存のモデルを他のMLプラットフォームから変換するために必要なもの、およびモデルの機能を拡張するカスタム操作の作成方法について説明します。

モデルをCore MLに変換したら、“Use model deployment and security with Core... ai,artificial intelligence,converters,core ml,core ml converters,core ml tools,custom operations,deep learning,learning,machine learning,mil,model,natural language,neural network,python,tensorflow,training WWDC20

Create ML Appの紹介

WWDC19

Create ML Appの紹介 Core MLのパワーをAppに組み込むには、「どうやってモデルを作成するか」という課題に取り組む必要があります。新しいCreate ML Appでは、直感的なワークフローでモデルを作成することができます。このセッションでは、この使いやすいツールで、モデルをすばやくトレーニング、評価、テスト、プレビューする方法について説明します。多数の強力な機械学習タスクを処理するためのテンプレートが数多く用意されていますので、その中の1つをまずお試しください。モデルの継続的な改良と実験のための多くの機能についても詳しく紹介します。 activity,ai,artificial intelligence,classifier,core ml,create ml,detection,image classification,learning,machine learning,model,motion,natural language,recommender,sound,tools,training,vision,xcode WWDC19

Core ML 3フレームワーク

WWDC19

Core ML 3フレームワーク Core ML 3は、これまでオンデバイスの機械学習では利用できなかった高度なモデルタイプに新たに対応しています。このセッションでは、モデルのパーソナライズにより、Appをパーソナライズできる度合いを大きく広げる方法について説明します。モデルをリンクさせる方法や、既存のモデルのコンバージョンに使うCore MLツールの向上点について、より深く理解していただけます。 ai,artificial intelligence,core ml,core ml tools,create ml,deep learning,learning,machine learning,model,natural language,neural network,sound,speech,training,vision WWDC19

機械学習における新機能

WWDC19

機械学習における新機能 Core ML 3が大幅に拡張され、これまで以上に高度なオンデバイスの機械学習機能をAppで利用できるようになりました。このセッションでは、さまざまなタスクのためのCore MLモデルを簡単に作成できる新しいCreate ML Appについて説明します。Vision、Natural Language、Sound、Speechの魅力的なアップデートや、最先端のモデルタイプに新たに対応したことや、モデルパーソナライズの概要についてご確認ください。 convertors,core ml,core ml tools,create ml,model personalization,models,natural language,neural networks,nlp,ondevice training,sound,speech,vision WWDC19

音声認識の最新情報

WWDC19

音声認識の最新情報 Speech Recognizerを、ネットワーク接続がなくても、iOSまたはmacOSデバイスでローカルに使用できようになりました。このセッションでは、プライバシーを保護し、サーバベースの処理における制限を排除しながら、Appをテキストから音声への変換に対応させる方法について説明します。また、音声認識のAPIが、話す速さ、休止の長さ、音声の品質など、より豊富な分析が行えるよう強化されたことについてもご確認いただけます。 machine learning,natural language,speech,speech recognition,speechtotext,voice,voice analysis WWDC19

Create MLで音声識別モデルをトレーニングする

WWDC19

Create MLで音声識別モデルをトレーニングする このセッションでは、オーディオファイルやライブオーディオストリームの音声を識別できるCore MLモデルをすばやく簡単に作成する方法を紹介します。音声識別モデルのトレーニングおよび評価機能に加えて、Create ML Appでは、Macのマイクロフォンを使用してリアルタイムでモデルのパフォーマンスをテストすることもできます。新しいSound Analysisフレームワークを使用して、Appで音声識別のオンデバイスモデルを活用しましょう。 ai,artificial intelligence,audio,classifier,core ml,create ml,machine learning,sound,training WWDC19

Create MLでオブジェクト検出モデルをトレーニングする

WWDC19

Create MLでオブジェクト検出モデルをトレーニングする オブジェクト検出のためのカスタムのCore MLモデルを使用すると、Appに魔法のような機能を追加できます。このセッションでは、XcodeのCreate ML Appによって、どのようにオブジェクト検出モデルを簡単にトレーニングおよび評価できるかについて説明します。また、コンティニュイティカメラを活用して、モデルのパフォーマンスをApp内で直接テストする方法も紹介します。Core ML向けの優れたオブジェクト検出モデルの構築とデプロイが、これまでになく簡単になりました。 ai,artificial intelligence,camera,classifier,core ml,core motion,create ml,images,machine learning,object detection,photos,training,vision WWDC19

Create MLでテキスト識別モデルをトレーニングする

WWDC19

Create MLでテキスト識別モデルをトレーニングする Create MLで、最先端のテクニックを基盤にした自然言語処理モデルを作成できるようになりました。このセッションでは、Create ML Appを使用して、テキスト識別モデルのトレーニングとテストを簡単に行う方法を紹介します。転移学習、単語の埋め込み、テキストカタログのための強力な新しいオプションについてご確認ください。 ai,artificial intelligence,classifier,core ml,create ml,gazetteer,machine learning,natural language,nlp,text,text catalog,training,word embeddings WWDC19

Understanding Images in Vision Framework

WWDC19

Understanding Images in Vision Framework Learn all about the many advances in the Vision Framework including effortless image classification, image saliency, determining image similarity, and improvements in facial feature detection, and face capture quality scoring. This packed session will show you how easy it is to bring powerful... camera,core ml,face capture quality,face detection,face landmarks,image classification,images,image similarity,machine learning,photos,saliency,vision WWDC19

Create MLでレコメンデーションモデルをトレーニングする

WWDC19

Create MLでレコメンデーションモデルをトレーニングする Core ML向けのレコメンデーションモデルを活用すると、Appを使用するお客様に、非常にパーソナルな体験を提供することができます。たとえば、毎日使用するAppで、再生する音楽や視聴する映画を提案できるようになります。このセッションでは、Create ML Appを使用して、あらゆる種類のデータソースからカスタムのレコメンデーションモデルを簡単に作成する方法について説明します。また、こうしたパーソナライズを、ユーザーのプライバシーを保護しながら実現する方法と、レコメンデーションモデルの例が実際に機能している様子もご確認いただけます。 ai,artificial intelligence,classifier,core ml,create ml,machine learning,object detection,personalization,recommendation,recommender,table,text,training WWDC19

Create MLでアクティビティ識別モデルを構築する

WWDC19

Create MLでアクティビティ識別モデルを構築する iPhoneとApple Watchには、加速度センサーやジャイロスコープなど、多数の強力なセンサーが搭載されています。こうしたセンサーからのデータを使用してアクティビティ識別モデルをトレーニングすると、ユーザーが走っていたりバットを振ったりしていることを感知するなど、Appに魔法のような機能を追加できます。このセッションでは、Create ML Appによって、このようなCore MLモデルの1つを簡単にトレーニングおよび評価できることについて説明します。トレーニングに必要な未加工のデータを収集する方法と、こうしたモデルが実際に使用されている様子についてご確認ください。 accelerometer,activity,ai,artificial intelligence,classifier,core ml,core motion,create ml,gyroscope,machine learning,motion,training WWDC19

Natural Languageフレームワークの最新情報

WWDC19

Natural Languageフレームワークの最新情報 Natural Languageは、すべてのAppleプラットフォームで自然言語処理タスク用のハイパフォーマンスなオンデバイスAPIを利用できるようにするためのフレームワークです。このセッションでは、Natural Languageフレームワークに追加されたセンチメント分析およびテキストカタログのサポートについて説明します。テキストベースのモデルで利用できる転移学習や、Appの検索機能を強化できる単語埋め込み機能に新たに対応したことについて、より深く理解していただけます。 classifier,core ml,language,machine learning,natural language,nlp,sentiment,text analysis,text catalog,transfer learning,word embeddings WWDC19

Core MLとARKitを使用して優れたAppを作成する

WWDC19

Core MLとARKitを使用して優れたAppを作成する Core MLやARKitなどのAppフレームワークを組み合わせて、教育用ゲームを作成していく様子を見てみましょう。このセッションでは、機械学習の力を活用して、Appで魔法のようなインタラクションを生み出す方法を紹介します。また、難しいコンピュータビジョンの問題を解決するためのアプローチについてより深く理解していただけます。インタラクティブなコーディングセッションで、Appが完成するプロセスについてご確認ください。 ,arkit,core ml,create ml,drawing classification,machine learning,object detection,pencil kit,speech recognition WWDC19

Visionフレームワークでのテキスト認識

WWDC19

Visionフレームワークでのテキスト認識 Visionフレームワークのドキュメントカメラ機能とテキスト認識機能を使用すると、画像からテキストデータを抽出することができます。このセッションでは、このビルトイン機械学習テクノロジーをAppで活用する方法について説明します。高速な処理と正確な処理の違いと、文字ベースでの認識と言語ベースでの認識の違いについて、詳しい情報についてご確認ください。 camera,document camera,images,natural language,photos,recognition,text,vision WWDC19

優れたML体験をデザインする

WWDC19

優れたML体験をデザインする 機械学習により、ユーザーが言ったことを理解し、ユーザーが好きなものを予測して提案し、ユーザーが新しい豊かな方法で自分を表現できる新しい体験を生み出すことが可能になります。また、機械学習は、日常のタスクを自動化し、やり取りの精度と速度を向上することで、既存の体験を向上させます。このセッションでは、ML体験をAppに組み込み、思い通りに操作できるユーザーインターフェイスを設計するための実践的なアプローチについて説明します。 WWDC19

機械学習のためのMetal

WWDC19

機械学習のためのMetal Metal Performance Shaders(MPS)には、機械学習およびGPUのパワフルな性能を活用するために不可欠な、データ並列処理プリミティブの厳選されたライブラリが収められています。iOS 13とmacOS Catalinaでは、MPSによってパフォーマンスが向上し、より多くのニューラルネットワークを活用できるようになりました。しかも、これまでより簡単に使用できるようになっています。このセッションでは、MPSのこうした向上点と、スタイル変換のような革新的なテクニックを実装するための実践的な方法について説明します。 WWDC19

7:28

7:28  23:45

23:45  30:32

30:32  32:59

32:59  29:40

29:40  24:36

24:36  19:29

19:29  25:31

25:31  17:54

17:54  22:11

22:11  20:08

20:08  23:24

23:24  19:27

19:27  26:49

26:49  18:56

18:56  20:22

20:22  19:07

19:07  20:03

20:03  12:24

12:24  11:32

11:32  18:15

18:15  17:01

17:01  16:06

16:06  16:49

16:49  17:33

17:33  10:55

10:55  23:48

23:48  9:19

9:19  18:21

18:21  34:29

34:29  21:18

21:18  16:31

16:31  21:49

21:49  22:49

22:49  26:02

26:02  17:56

17:56  30:09

30:09  25:06

25:06  18:38

18:38  13:47

13:47  16:50

16:50  19:56

19:56  14:25

14:25  14:38

14:38  21:15

21:15  23:21

23:21  25:18

25:18  17:35

17:35  7:52

7:52  16:46

16:46  25:31

25:31  12:11

12:11  23:30

23:30  13:25

13:25  19:48

19:48  29:51

29:51  17:19

17:19  15:48

15:48  23:48

23:48  25:18

25:18  36:34

36:34  32:44

32:44  19:16

19:16  17:58

17:58  26:49

26:49  16:49

16:49  19:12

19:12  14:22

14:22  24:30

24:30  29:12

29:12  26:06

26:06  24:42

24:42  24:21

24:21  36:27

36:27  24:35

24:35  41:04

41:04  11:48

11:48  18:39

18:39  39:35

39:35  31:16

31:16  14:34

14:34  40:38

40:38  14:49

14:49  6:10

6:10  20:11

20:11  15:41

15:41  12:05

12:05  39:50

39:50  10:31

10:31  15:01

15:01  39:19

39:19  29:43

29:43  38:15

38:15  57:45

57:45  41:25

41:25