機械学習にもとづくビデオエフェクトでアプリを強化

WWDC25

機械学習にもとづくビデオエフェクトでアプリを強化 フレームレート変換、超高解像度、ノイズフィルタなどのエフェクトを追加して、ビデオ編集やライブストリーミングの体験を向上させる方法を学びましょう。Video Toolboxフレームワークに搭載され、Appleシリコン向けに最適化された機械学習にもとづくビデオ処理アルゴリズムについて詳しく説明します。これらのエフェクトを統合し、実際のユースケースで利用できるようにアプリの機能を向上させる方法について解説します。 WWDC25

visionOS 26の新機能

WWDC25

visionOS 26の新機能 visionOS 26のエキサイティングな新機能について学びましょう。強化されたVolumetric APIについて解説し、SwiftUI、RealityKit、ARKitの機能を組み合わせる方法を紹介します。より高速なハンドトラッキングと空間アクセサリからの入力を使用して、魅力的なアプリとゲームを開発する方法について説明します。SharePlay、Compositor Services、イマーシブなメディア、空間Web、Enterprise APIなどの最新アップデートの概要をいち早くご確認いただけます。 arkit,audio,audio amp video,business,businessconnect,compositorservices,enterprise,games,immersive,occlusion,quicklook,quick look,realitykit,realitykit audio,safari,safari amp web,shareplay,spatial,spatial accessories,spatial audio,spatial computing,swiftui,tabletopkit,video,visionos,web,widgetkit WWDC25

キャプチャコントロールによるカメラ体験の向上

WWDC25

キャプチャコントロールによるカメラ体験の向上 カメラ体験でのキャプチャコントロールをカスタマイズする方法を学びましょう。新しいAirPodsサポートなど、物理的なキャプチャコントロールを使って写真を撮影する方法や、カメラコントロールで設定を調整する方法を紹介します。 avfoundation,camera,capture WWDC25

アプリの音声録音機能の強化

WWDC25

アプリの音声録音機能の強化 アプリの音声録音機能を向上させる方法を学びましょう。iOSおよびiPadOS26の入力ピッカーインタラクションを使用して、オーディオデバイスを柔軟に選択する方法や、AirPodsで高品質な音声録音を行うためのAPIを紹介します。また、発話と環境音の分離を実現するAudioToolbox、AVFoundation、Cinematicの各種フレームワークを使用した空間オーディオの収録および編集の機能の概要も説明します。 WWDC25

アプリでのシネマティックビデオの撮影

WWDC25

アプリでのシネマティックビデオの撮影 Cinematic Video APIを使って、シネマスタイルのビデオをアプリで簡単に撮影する方法を紹介します。シネマティック撮影セッションの設定方法や、ビデオ撮影UIの構築の基本について説明します。被写界深度のエフェクトを適用してトラッキングとRack Focus(ピン送り)を実現するなど、高度なシネマティック機能についても解説します。 camera,capture,cinematic WWDC25

visionOS向けエンタープライズAPIのご紹介

WWDC24

visionOS向けエンタープライズAPIのご紹介 visionOS向けの新しいエンタープライズAPIを使用して、Apple Vision Proで従業員やユーザーの生産性を高める空間体験を創出する方法を学びましょう。 WWDC24

魅力的な空間写真と空間ビデオの作成

WWDC24

魅力的な空間写真と空間ビデオの作成 空間写真と空間ビデオをアプリに取り入れる方法について説明します。さまざまなタイプのステレオスコピック(立体)メディアを紹介し、iPhone 15 Pro上のiOSアプリに空間ビデオを取り入れる方法を解説します。visionOSの新しいQuickLook Preview Application APIなど、空間メディアを検知して表示するためのさまざまな方法を確認しましょう。写真やビデオを空間対応にするメタデータとステレオの概念についても詳しく説明します。 audio amp video,camera,machine learning,photokit,spatial photos and videos WWDC24

すべてのキャプチャで色の一貫性を維持

WWDC24

すべてのキャプチャで色の一貫性を維持 Constant Color APIの概要と、正確な色を判断するための機能をアプリで提供するうえでこのAPIがどのように役立つかをご紹介します。APIの導入方法、このAPIが科学およびマーケティングの領域にもたらす可能性、この技術を最大限に活用するためのベストプラクティスを学ぶことができます。 camera,color,colorspace,machine learning,photos WWDC24

ロック画面での優れたカメラキャプチャ体験の構築

WWDC24

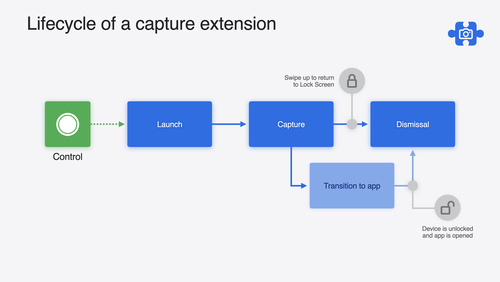

ロック画面での優れたカメラキャプチャ体験の構築 LockedCameraCapture APIにより、キャプチャアプリの最も有用な情報をロック画面に直接取り込む方法について説明します。このAPIの機能を確認した後、キャプチャ拡張機能の作成を開始する方法をご紹介します。さらに、デバイスがロックされているとき、キャプチャ拡張機能がどのように動作するかについても解説します。 camera,lock screen,machine learning WWDC24

HDRを使用してアプリのダイナミックイメージ体験を向上

WWDC24

HDRを使用してアプリのダイナミックイメージ体験を向上 HDR画像を読み書きする方法、およびアプリでHDRコンテンツを処理する方法について説明します。新たにサポートされたHDR画像形式と、HDR画像を表示するための高度な方法を確認しましょう。HDRコンテンツをユーザーインターフェイスと共存させる方法に加え、HDR画像のサポートをアプリに追加する際の注意事項も取り上げます。 adaptive,camera,hdr,photokit,photos WWDC24

DockKitの新機能

WWDC24

DockKitの新機能 被写体間のスムーズな切り替えを可能にする、DockKitのインテリジェントトラッキングについて説明します。インテリジェントトラッキングとは何か、インテリジェントトラッキングがMLモデルを使用して被写体を選択し、トラッキングする仕組み、この機能をアプリに取り入れる方法をご紹介します。 camera,dock,intelligence,machine learning,object detection WWDC24

アプリの動画でのシネマティックモードへの対応

WWDC23

アプリの動画でのシネマティックモードへの対応 Cinematic Camera APIを使って、カメラアプリで撮影されたシネマティックモードの動画にアプリで対応する方法を紹介します。判定レイヤーなどを含む、シネマティックモードのビデオを構成する基本的な要素について解説します。また、アプリで判定にアクセスして更新する方法を紹介し、変更の保存とその読み込み/書き出しの方法についても解説します。 WWDC23

より応答性の高いカメラ体験の実現

WWDC23

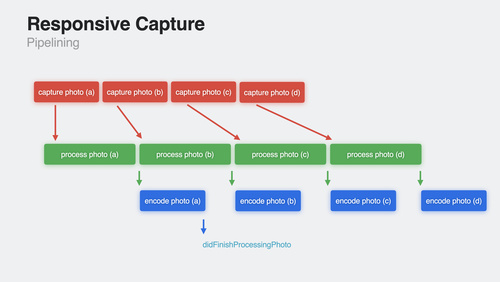

より応答性の高いカメラ体験の実現 AVCaptureとPhotoKitが、より応答性の高い、楽しいアプリの作成にどのように役立つかをご確認ください。カメラのキャプチャプロセスについて確認し、写真の遅延処理が最高品質の写真を作成するのにどのように役立つかをご覧ください。ゼロシャッターラグでタイムトラベルを使用して完璧なアクション写真をキャプチャする方法を紹介し、応答性の高いキャプチャパイプラインの構築について詳しく説明します。また、ビデオエフェクトAPIを採用して、リアルタイムのビデオエフェクトをトリガーする事前定義されたジェスチャを認識する方法に関しても共有します。 WWDC23

アプリ内でのHDR画像のサポート

WWDC23

アプリ内でのHDR画像のサポート アプリ内でハイダイナミックレンジ(HDR)静止画像を識別、ロード、表示する方法を学びましょう。一般的なHDRの概念を詳しく学び、ISO規格への最新アップデートを確認しましょう。SwiftUIやUIKitを使ってHDR画像をどのように識別し表示するのか、ProRAWおよびRAWキャプチャからどのように作成するのか、CALayerでどのように表示するのかについて学びましょう。ISO HDRのためのCoreGraphicsサポートについても説明し、HDRを採用する最善方法を紹介します WWDC23

tvOS向けの連携カメラ機能

WWDC23

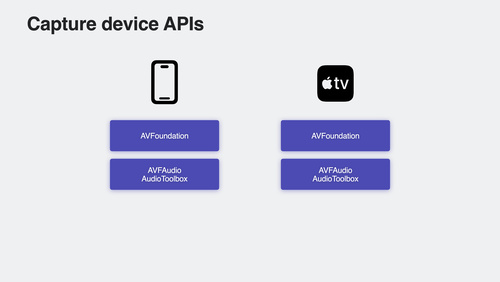

tvOS向けの連携カメラ機能 tvOS向けのアプリにAVFoundation、AVFAudio、およびAudioToolboxを取り入れ、リビングルーム向けのカメラとマイクの体験を作成する方法について紹介します。Device Discovery APIを使用して既存のiOSカメラ体験によってtvOSをサポートする方法、iPhoneをWebカメラまたはFaceTimeのソースとして使用するアプリを構築する方法、およびtvOS向けに開発する際の特別な考慮事項について確認します。また、tvOSの音声録音を有効にする方法や、エコーキャンセレーションを使用して優れた音声操作の体験を作成する方法についても紹介します。 WWDC23

iPadOSアプリで外部カメラをサポート

WWDC23

iPadOSアプリで外部カメラをサポート AVFoundation capture classesを使用しiPadOSアプリで外部カメラに接続する方法を学びます。外部及び内蔵カメラの両方からのビデオを回転させる方法や、USB-Cで外部マイクをサポートし、オーディオルーティングする方法をご紹介します。電話サポートやエコーキャンセレーションの調整、そして外部カメラの適応におけるベストプラクティスを探求します。 WWDC23

DockKitを利用した電動iPhoneスタンドとの統合

WWDC23

DockKitを利用した電動iPhoneスタンドとの統合 DockKitと互換性がある電動スタンドと統合して、カメラアプリで素晴らしい写真やビデオの体験を作成する方法を紹介します。 アプリが360度の視野全体でライブビデオ内の被写体を自動的にトラッキングし、スタンドを直接制御してフレーミングをカスタマイズしたり、モーターを直接制御したり、他のオブジェクトのトラッキングのための独自の推論モデルを提供したりする方法を説明します。 最後に、動的なデバイスアニメーションを通じて感情を演出する方法も紹介します。 画像トラッキング技術の詳細については、WWDC23の「Visionで動物のポーズを検出」および WWDC21 の「Create... WWDC23

ScreenCaptureKitの新機能

WWDC23

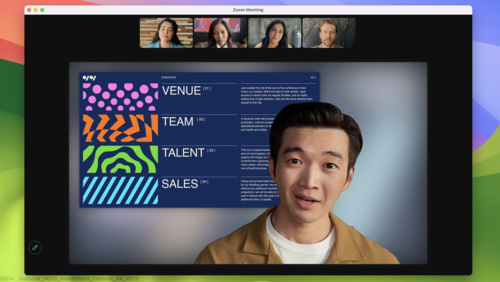

ScreenCaptureKitの新機能 ScreenCaptureKitの最新機能を使って、画面共有の体験をレベルアップしましょう。ビルトインのシステムピッカー、プレゼンターオーバーレイ、スクリーンショット機能を探求し、これらの機能を既存のScreenCaptureKitアプリやゲームに組み込む方法を学びましょう。 WWDC23

写真ピッカーのアプリへの組み込み

WWDC23

写真ピッカーのアプリへの組み込み アプリから簡単かつ安全で確実に写真ライブラリにアクセスする方法を紹介します。組み込みPickerの利用開始方法や、オプションメニュー、HDR静止画像サポートについて説明します。また、Pickerが既存のインターフェイスに馴染むようUIのカスタマイズオプションの活用方法についても紹介します。 WWDC23

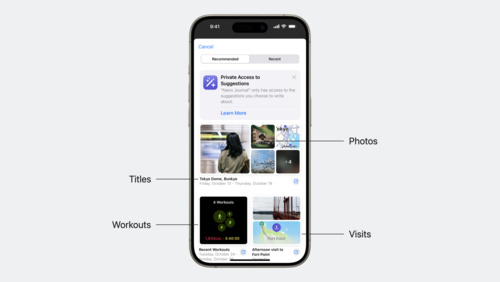

Journaling Suggestions APIの紹介

Tech Talks

Journaling Suggestions APIの紹介 プライバシーを保護しながら、ユーザーがアプリを通じて日常生活のちょっとした出来事や大切な思い出を振り返るのに役立つ、新しいJournaling Suggestions APIについて紹介します。このAPIを活用してジャーナル記録の提案用のアセットとメタデータを取得する方法、アプリ上にピッカーを呼び出す方法、提案されたコンテンツをユーザーが保存できるようにする方法などを確認しましょう。 Tech Talks

リファレンスモードについて

Tech Talks

リファレンスモードについて iPad Pro 12.9インチのLiquid Retina XDRディスプレイでリファレンスモードを使用して、プロのワークフローで求められる、ハイレベルなカラー要件に対応する方法を説明します。レビュー、承認、合成、カラーグレーディングなどのワークフローにおいて、リファレンスモードを使用して、色を正確に表現する方法、および一貫性のある画像表示を可能にする方法を紹介します。また、リファレンスモードと共に使用するAPI、リファレンスモードの機能および対応するメディア形式、Sidecarでリファレンスモードを活用する方法についても説明します。 Tech Talks

iOS 11でのQRコードの認識

Tech Talks

iOS 11でのQRコードの認識 iOS 11は、QRコードを検出および処理するためのビルトインのサポートを提供しています。サポートされているQRコードの種類、それぞれのタイプがビルトインカメラとSafariでどのように処理されるか、またQRコードをスキャンした際にUniversal LinksがどのようにシームレスにAppに誘導するかについて説明します。 Tech Talks

VisionKitで機械可読コードやテキストをキャプチャする

WWDC22

VisionKitで機械可読コードやテキストをキャプチャする VisionKitのData Scannerとは:このフレームワークは、AVCaptureとVisionを組み合わせて、シンプルなSwift APIで機械可読コードやテキストをライブキャプチャできるようにするものです。ここでは、バーコードの種類や言語選択を指定して、Appがキャプチャできるコンテンツの種類を制御する方法を紹介します。また、Appのガイダンスを有効化したり、項目のハイライト表示や関心領域をカスタマイズしたり、Appで項目が検出されたときにインタラクションを処理したりする方法も紹介します。 静止画または一時停止したビデオフレームでのLive... WWDC22

連係カメラをmacOS Appに導入する

WWDC22

連係カメラをmacOS Appに導入する 連係カメラ搭載のMac Appで、iPhoneを外部カメラとして使用する方法をご覧ください。テレビ会議ソフトウェアを構築する場合でも、カメラを工夫して使用するAppを開発する場合でも、カメラの自動切り替え機能を使用して、Appの体験を向上させる方法を紹介します。また、ユーザー優先またはシステム優先のカメラを識別する方法をはじめ、iPhoneのビデオストリームから高解像度かつ高品質の写真をキャプチャするAPIなども紹介します。 カメラキャプチャの詳細については、WWDC22の「iOSカメラキャプチャの進歩を知る」をご覧ください。 WWDC22

iOSカメラキャプチャの進歩を知る:奥行き、フォーカス、マルチタスク処理

WWDC22

iOSカメラキャプチャの進歩を知る:奥行き、フォーカス、マルチタスク処理 Appで高度なカメラキャプチャ機能を活用する方法をご覧ください。LiDARスキャナで写真や動画のエフェクトを作り出したり、正確な奥行きを測定したりする方法を紹介します。カメラでピクチャ・イン・ピクチャやマルチタスク処理が行われる仕組みや、顔認識によるオートフォーカスや自動露出が制御される仕組みなどについて解説します。また、複数のビデオ出力を使用する戦略も紹介します。これにより、高品質のビデオ出力をキャプチャしながらライブプレビューを最適化することもできるようになります。 カメラキャプチャ機能の概要については、WWDC21の「カメラキャプチャの新機能」をご覧ください。 WWDC22

RoomPlanによるパラメトリックな3Dルームスキャンの作成

WWDC22

RoomPlanによるパラメトリックな3Dルームスキャンの作成 RoomPlanを使用すると、Appで簡単にパラメトリックな3Dルームスキャンを作成できるようになります。このAPIを使って、部屋のスキャン体験を簡単に実現する方法をご確認ください。このAPIを組み込む方法、3Dのパラメトリックな出力、Appで優れた結果を得るためのベストプラクティスについても紹介します。 ar,arkit,augmented reality WWDC22

Live TextのインタラクションをAppに追加する

WWDC22

Live TextのインタラクションをAppに追加する 静止画や一時停止したビデオフレームのLive TextサポートをAppに追加する方法をご覧ください。iOS、iPadOS、macOS上の画像ビュー内で、テキストの操作、翻訳、データ検出、QRコードスキャンを簡単に有効化する方法を紹介します。また、インタラクションするタイプの指定、補助的なインターフェイスの管理、潜在的なジェスチャーの競合を解消する方法も紹介します。 ライブカメラのプレビューで検出されたデータでのキャプチャやインタラクションの詳細については、WWDC22の「VisionKitで機械可読コードやテキストをキャプチャする」をご覧ください。 WWDC22

iOSのEDRの詳細

WWDC22

iOSのEDRの詳細 EDRは、AppleのHigh Dynamic Range表示やレンダリングのパイプラインです。AppのEDRを使用してHDRコンテンツをレンダリングし、iPhoneやiPadのHDRディスプレイでのダイナミックレンジ機能を最大限に活用する方法について解説します。iOSのネイティブEDR APIを活用する方法、HDRの利用が適切だと判断するベストプラクティス、トーンマッピングやHDRコンテンツレンダリングのヒント、そしてReference... WWDC22

Core Image、Metal、SwiftUIでのEDRコンテンツの表示

WWDC22

Core Image、Metal、SwiftUIでのEDRコンテンツの表示 Core ImageベースのマルチプラットフォームSwiftUI Appから、レンダリングのサポートにExtended Dynamic Range(EDR)を追加する方法をご覧ください。ここでは、ViewRepresentableを使用して、CIImagesをMTKViewに表示するベストプラクティスを紹介します。また、EDRレンダリングを有効化する簡単な手順や、EDRをサポートする内蔵CIFilter(150個以上)の例も紹介します。 WWDC22

PhotoKitの変更履歴について

WWDC22

PhotoKitの変更履歴について PhotoKitにより、写真を中心とした豊富な機能を構築できるようになります。PhotoKitの最新APIを使用して、画像アセットへの変更を簡単に追跡する方法について解説します。さらに、PHPhotoLibraryのchange historyAPIを紹介し、起動時に変更トークンを保持する方法、Appで他のユーザの写真ライブラリへの追加、削除、更新を認識できるようにする方法についても紹介します。 写真ライブラリの統合に関する詳細については、WWDC22の「写真ピッカーの最新情報」と、WWDC21の「App内の写真アクセスの改善」をご覧ください。 WWDC22

写真ピッカーの最新情報

WWDC22

写真ピッカーの最新情報 PHPickerにより、ご利用のAppとシステムの写真ライブラリ間での簡単かつ安全な統合が実現します。SwiftUIやTransferableが、iOS、iPadOS、macOS、WatchOSにわたって統合を提供する仕組みをご覧ください。 また、AppKitやNSOpenPanelを使用して、Macの写真ピッカーをご利用のmacOS向けのAppに取り込む方法も紹介します。 写真ピッカーの詳細については、WWDC21の「App内の写真アクセスの改善」をご覧ください。 WWDC22

Core Media IOでカメラExtensionを作成する

WWDC22

Core Media IOでカメラExtensionを作成する Core Media IOを使用して、ソフトウェアカメラ、ハードウェアカメラ、クリエイティブカメラのmacOSシステム拡張機能を簡単に作成する方法をご覧ください。従来のDALプラグインに代わる最新機能を紹介します。このExtensionには、カメラ入力を使用するAppと完全な互換性があり、安全性や高速性にも優れています。さらに、Core Media IO APIについて解説し、カメラメーカー、特殊効果機能付きテレビ会議App、クリエイティブAppのアイデアなどをサポートする方法も紹介します。 WWDC22

AVFoundationやMetalによるHDR動画のEDR表示

WWDC22

AVFoundationやMetalによるHDR動画のEDR表示 AVFoundationやMetalを活用して効率的なEDRパイプラインを構築する方法を紹介します。そして、AVPlayerを使用してHDR動画をEDRで表示したり、ビデオ再生をAppビューに追加したり、Metalでレンダリングしたり、Core ImageやカスタムMetalシェーダを使用してキーイングやカラーマネジメントなどのビデオエフェクトを追加したりする方法について解説します。ゲーム開発でもPro App開発でも、使用するフレームワーク選びで役立つことでしょう。さらに、トランスポート、カラースペース、ピクセルバッファのフォーマット選びに関するベストプラクティスも紹介します。 WWDC22

VideoToolboxによる低遅延ビデオエンコーディング

WWDC21

VideoToolboxによる低遅延ビデオエンコーディング 低遅延エンコーダーをサポートすることは、ビデオApp開発プロセスの重要な側面となっています。VideoToolboxがどのように低遅延のH.264ハードウェアエンコーディングをサポートし、エンドツーエンドのレイテンシを最小化し、最適なリアルタイムコミュニケーションと高品質のビデオ再生に向けて新たなレベルのパフォーマンスを達成するかを確認します。 acceleration,avfoundation,coremedia,hardware,performance,video,videotoolbox WWDC21

Appのキーボード入力のためのカメラの使用

WWDC21

Appのキーボード入力のためのカメラの使用 テキストの認識表示をサポートし、カメラからテキストデータをインテリジェントに取り込んで、App内のフォームやテキストフィールドに入力する方法を確認しましょう。ユーザがカメラをキーボード代わりに使用してテキストを入力する際に、コンテンツフィルタリングを適用して正しい情報を抽出して、その情報を適切なUITextFieldに取り込む方法を紹介します。これにより、Appで電話番号、住所、フライト情報などのデータを入力できるようになります。カスタムインターフェイスを作成して、UIImageViewsのような他のコントロールを拡張してこの機能をサポートする方法なども検証します。... camera,input,keyboard,keyboard as input,ocr,text recognition WWDC21

ProRAW画像の撮影と処理

WWDC21

ProRAW画像の撮影と処理 AppでProRAWをサポートすると、標準のRAW情報をAppleの高度なコンピュテーショナルフォトグラフィ技術と組み合わせることで、フォトグラファーが画像を簡単に取り込んで編集できるようになります。まず、ProRAW画像のルック&フィール、クオリティメトリクス、Appとの互換性などといったフォーマットの概要を説明します。さらに、AVFoundationを使った画像の取り込み、PhotoKitを使ったストレージ、Core Imageを使った編集など、制作パイプラインのあらゆる段階でProRAWをAppに取り入れる方法を紹介します。 coreimage,filters,photo effects,photography,photos WWDC21

Create MLフレームワークを使ったダイナミックなiOS Appの構築

WWDC21

Create MLフレームワークを使ったダイナミックなiOS Appの構築 Create MLフレームワークを使って、Core MLモデルを完全にデバイス上でトレーニングすることで、データのプライバシーを守りながら、適応性の高いカスタマイズされたAppエクスペリエンスを実現する方法を紹介します。スタイル変換や画像識別といった画像ベースのタスク、カスタム音声識別などのオーディオタスク、またはテキスト識別、表形式データの識別、および表形式データの回帰分析などのタスクといった、オンザフライ方式で作成できるモデルタイプについて確認します。また、Appをよりパーソナルでダイナミックなものにするため、これらのモデルから提供される多数の可能性を紹介します。... ai,core ml,create ml,create ml framework,machine learning,ondevice training WWDC21

カメラキャプチャの新機能

WWDC21

カメラキャプチャの新機能 コントロールセンターでビデオエフェクト(センターフレーム、ポートレートモード、マイクモードなど)を操作する方法を確認しましょう。これらの機能がAppに対して有効化されたタイミングを検出する方法について紹介し、これらの機能をApp内から制御可能にするためのカスタムインターフェイスを導入する方法を検証します。10ビットのHDRビデオキャプチャを有効にして、ミニマムフォーカスディスタンスレポーティングを利用してカメラキャプチャの体験を向上させる方法を紹介します。IOSurface圧縮のサポートと、カメラキャプチャのパフォーマンス最適化についても検証します。... avcapture,camera,microphone,photo,photography,video,video effects WWDC21

Core Imageカーネルの改善点

WWDC21

Core Imageカーネルの改善点 Metal Shading Language で書かれた Core Image カーネルをAppに追加する方法を確認します。Metal Shading Languageで記述されたCore ImageカーネルのためにXcodeルールと命名規則をどのように使用するかを検討し、Core Imageカーネルに役立つMetalのStitchable関数とダイナミックライブラリ機能を理解できるようにします。 coreimage,filters,hardware,image,image processing,metal,metal shading language,metal tools,photos WWDC21

ビデオフォーマットを使ったハイクオリティな写真の撮影

WWDC21

ビデオフォーマットを使ったハイクオリティな写真の撮影 AVCapture APIを使用すれば、iPhoneの強力なカメラシステムをAppで最大限に活用できます。写真のクオリティと配信速度のトレードオフのバランスを取りながら、ユースケースに最適な写真やビデオのフォーマットを選択する方法について確認します。また、Appでビデオフォーマットを使用する際に、写真のクオリティを大幅に向上させることができる強力な新しいアルゴリズムについても確認します。 AVCaptureの改良点については、「カメラキャプチャの新機能」のビデオも是非ご確認ください。 avcapture,camera,photography,video WWDC21

EDRによるHDRレンダリング

WWDC21

EDRによるHDRレンダリング EDRはAppleのハイダイナミックレンジ表現とレンダリングパイプラインです。AppでEDRを使用してHDRコンテンツをレンダリングし、Appleの内蔵ディスプレイやPro Display XDRなどのHDRディスプレイのダイナミックレンジ性能を引き出す方法を紹介します。 ゲームやプロ向けAppのデベロッパが、macOSのネイティブEDR APIを活用して操作性をさらに向上させる方法や、HDRが適切かどうかの判断、トーンマッピングの適用、HDRコンテンツの配信に関するベストプラクティスを紹介します。 display,display p3,edr,hdr,metal,metal shading language WWDC21

App内の写真アクセスの改善

WWDC21

App内の写真アクセスの改善 PHPickerは、PhotosライブラリをAppに統合するための最もシンプルで安全な方法ですが、さらに進化しています。Appで画像を順番に選択する方法や、ピッカが表示されているときにアセットを事前に選択する方法を紹介します。また、PhotoKitを使ってさらに深いレベルでのインテグレーションが必要となるAppのために、PHCloudIdentifierを使用して写真プロジェクトのコンテンツをデバイス間で同期する方法を解説します。この方法によって、iPhone、iPad、Mac間での画像作業の移行が容易になります。 また、Limited Photos... limited library,limited photos library,photokit,photos,photos api,photos library,picker WWDC21

Xcodeを使用したMetalベースCore Imageカーネルの作成

WWDC20

Xcodeを使用したMetalベースCore Imageカーネルの作成 Metal Shading Languageで書かれたCore ImageカーネルをAppに統合してロードする方法について学びます。また、これらの画像フィルタを適用して独自のエフェクトを作成する方法についても説明します。Metal Shading Languageで書かれたCore ImageカーネルのXcode規則と命名規則の使用方法を紹介します。MetalおよびMetal Shading Languageを用いて、Core Image APIを効果的かつ最適に使用する方法について説明します。 coreimage,graphics,image processing,metal,performance,video,xcode WWDC20

動画AppのためのCore Imageパイプラインの最適化

WWDC20

動画AppのためのCore Imageパイプラインの最適化 Core Imageの処理能力を活用し、App内の動画パフォーマンスを最適化する方法について説明します。あなたのAppで動画にエフェクトを適用するためのCore Imageパイプラインを構築する方法を紹介します。CIContextを使用するときに、Appのメモリのフットプリントを減らす方法、およびCore Imageフィルタを使用した動画再生のためのAVPlayViewまたはMTKViewビュークラスの使用に関するベストプラクティスについて学びます。さらに、独自のカスタムカーネルをMetal Shading Languageで書くべき理由について説明し、Core... coreimage,graphics,image processing,metal,performance,video WWDC20

AppでのLimited Photos Libraryの活用

WWDC20

AppでのLimited Photos Libraryの活用 プライバシーを保護しつつ、Appに必要な写真と動画にアクセスします。新しいLimited Photos Library機能により、Appがアクセスできる写真や動画を直接制御してプライベートコンテンツを保護できます。この機能があなたのAppにどのような影響を与えるかを考え、PHPickerなどの代替案を検討しましょう。

PHPickerの詳細について、さらに、この完全にプライベートなピッカーが、あなたのAppで完全なPhotos Libraryアクセスを必要としないようにする上でどう役に立つのかについては、“Meet the New Photos Picker”を参照してください。 photokit,photo library,photos,photos api,picker,privacy WWDC20

Discover Core Imageデバッグ技術

WWDC20

Discover Core Imageデバッグ技術 Xcode環境変数を使用して、Core Imageパイプライン内のレンダリングおよび最適化の問題を検出して、修正します。Core Imageグラフを可視化するための環境変数の設定方法を紹介します。Core Imageグラフの生成方法、およびそれを解釈してメモリ、色、およびパフォーマンスの問題を発見し、Core Imageパイプラインを改善および最適化する方法について学びます。 coreimage,graphics,image processing,metal,performance,video,xcode WWDC20

新しいPhotosピッカーの紹介

WWDC20

新しいPhotosピッカーの紹介 Photo Libraryへの完全なアクセスがなくても、Appで使用する写真や動画を選択することができます。PHPicker API for iOSとMac Catalystによって、必要な機能をAppに提供しつつプライバシーを確保する方法について説明します。... photokit,photo library,photos,photos api,picker,privacy WWDC20

Computer Vision APIの探求

WWDC20

Computer Vision APIの探求 Core Image、Vision、およびCore MLを組み合わせることで、AppにComputer Vision のインテリジェンスを導入する方法について学びます。機械学習だけにとどまらず、画像や動画の理解を深めましょう。Core ImageおよびVisionにおける新しいAPIを見つけ、新しいしきい値フィルター、輪郭検出(Contour Detection)、フレーム間予測(Optical Flow)などのAppにComputer Visionを取り入れます。また、Core Imageを使用して、これらの結果の前処理と可視化を行う方法を検討します。... cifilter,ci filters,ciimage,cikernel,computer vision,contour,core image,core ml,machine learning,optical flow,trajectory,vision,visualization WWDC20

ReplayKitを使用したMac上でのAppの取り込みとストリーミング

WWDC20

ReplayKitを使用したMac上でのAppの取り込みとストリーミング ReplayKitをMac Appやゲームに統合し、簡単に画面録画を共有したり、ライブオーディオやビジュアルをオンラインで放送したりする方法について学びます。Mac App内に画面コンテンツ、オーディオ、およびマイクの入力を取り込み、さらに動画をライブ視聴者に放送する方法を紹介します。

Appでこのフレームワークを使用する方法の詳細については、 “Live Screen Broadcast with ReplayKit”および"What's New with Screen Recording and Live Broadcast"を参照してください。 WWDC20

フォトセグメンテーションマットの紹介

WWDC19

フォトセグメンテーションマットの紹介 iOS 12のポートレートモードで撮影された写真には、人物のセグメンテーションマットが埋め込まれており、背景の置換などのクリエイティブな視覚効果を簡単に作成することができます。iOS 13では、オンデバイスの機械学習を活用することにより、撮影されたあらゆる写真に新規のセグメンテーションマットを追加することができます。このセッションでは、人物の髪、肌、歯を分離できる、AVCaptureとCore... avcapture,camera,core image,hair,images,matte,photos,portrait effects,segmentation,skin,teeth WWDC19

Understanding Images in Vision Framework

WWDC19

Understanding Images in Vision Framework Learn all about the many advances in the Vision Framework including effortless image classification, image saliency, determining image similarity, and improvements in facial feature detection, and face capture quality scoring. This packed session will show you how easy it is to bring powerful... camera,core ml,face capture quality,face detection,face landmarks,image classification,images,image similarity,machine learning,photos,saliency,vision WWDC19

カメラキャプチャとフォトセグメンテーションの最新情報

WWDC19

カメラキャプチャとフォトセグメンテーションの最新情報 AVCapture APIの強力な新機能を使用すると、複数のカメラから同時に写真やビデオをキャプチャできます。写真では、写真の中の髪、肌、歯を分離できるセマンティックセグメンテーションが利用できるようになりました。このセッションでは、こうした向上点によって優れたカメラAppを作成し、目を見張るような写真効果を簡単に生み出す方法を紹介します。 avcapture,avfoundation,camera,core image,hair,images,microphone,multi camera,photos,portrait effects,segmentation,skin,spatial audio,teeth,video WWDC19

iOSの複数カメラキャプチャの紹介

WWDC19

iOSの複数カメラキャプチャの紹介 iOS 13のAVCaptureでは、iPhone XS、iPhone XS Max、iPhone XR、最新のiPad Proの複数のカメラで写真とビデオを同時にキャプチャすることができるようになりました。また、デバイスで複数のマイクロフォンを構成して、キャプチャした音声を合成することもできます。このセッションでは、こうした強力な機能を活用して、Picture in Pictureや立体音響といったクリエイティブな新機能を自作のカメラAppに組み込む方法について説明します。また、Appのデザインに影響を与える可能性がある、パフォーマンスに関する考慮事項もご確認いただけます。 avcapture,avfoundation,capture,core image,depth,disparity,hair,microphone,multi camera,parallax,photo effects,photography,photos,photos api,portrait mode,segmentation,skin,spatial audio,teeth WWDC19

High Efficiency Image File Format

WWDC17

High Efficiency Image File Format Learn the essential details of the new High Efficiency Image File Format (HEIF) and discover which capabilities are used by Apple platforms. Gain deep insights into the container structure, the types of media and metadata it can handle, and the many other advantages that this new standard affords. WWDC17

Capturing Depth in iPhone Photography

WWDC17

Capturing Depth in iPhone Photography Portrait mode on iPhone 7 Plus showcases the power of depth in photography. In iOS 11, the depth data that drives this feature is now available to your apps. Learn how to use depth to open up new possibilities for creative imaging. Gain a broader understanding of high-level depth concepts and... capture,depth,disparity,parallax,photo effects,photography,photos,photos api,portrait mode WWDC17

AVCapturePhotoOutput - Beyond the Basics

WWDC16

AVCapturePhotoOutput - Beyond the Basics Continue your learning from Session 501: Advances in iOS Photography, with some additional details on scene monitoring and resource management in AVFoundation's powerful new AVCapturePhotoOutput API. camera,capture,editing,image,jpg,live photo,photo,raw WWDC16

Advances in iOS Photography

WWDC16

Advances in iOS Photography People love to take pictures with iPhone. In fact, it's the most popular camera in the world, and photography apps empower this experience. Explore new AVFoundation Capture APIs which allow for the capture of Live Photos, RAW image data from the camera, and wide color photos. camera,capture,editing,image,jpg,live photo,photo,raw WWDC16

16:57

16:57  38:47

38:47  19:20

19:20  19:19

19:19  18:27

18:27  21:18

21:18  21:52

21:52  23:48

23:48  22:49

22:49  34:29

34:29  16:06

16:06  24:53

24:53  34:57

34:57  28:58

28:58  29:12

29:12  32:41

32:41  17:35

17:35  13:43

13:43  14:16

14:16  14:05

14:05  12:50

12:50  9:16

9:16  12:11

12:11  19:41

19:41  18:22

18:22  16:29

16:29  14:26

14:26  20:36

20:36  17:41

17:41  10:00

10:00  14:30

14:30  32:08

32:08  22:04

22:04  19:57

19:57  11:34

11:34  26:31

26:31  16:49

16:49  36:02

36:02  9:03

9:03  14:39

14:39  34:16

34:16  17:58

17:58  6:12

6:12  8:37

8:37  14:17

14:17  7:16

7:16  14:33

14:33  24:35

24:35  23:58

23:58  15:33

15:33  39:50

39:50  60:34

60:34  44:40

44:40  29:05

29:05  58:39

58:39  20:44

20:44  59:42

59:42